AIガバナンス体制の強化でリスクと競争力を同時に管理

- 全AIユースケースをリストアップし、7日以内に現状の管理レベルを自己評価

自社の弱点や改善点が明確になり、不正利用や事故の予防につながる

- ベンダー選定時、チェックポイント5項目(透明性・ポリシー継承・拡張性・UI操作性・法規適合)を必ず書面で確認

導入後の運用トラブルや追加コスト発生率が大幅に減る

- *AI活用部門ごと*に担当者を1名以上指名し、30日以内に倫理教育プログラムへ参加させる

*人的エラーや不正アクセス*対策として意識改革できる

- *公式ガイドラインと専門家(法律/金融/ITセキュリティ)への相談窓口*を導入前から併設

誤った設計判断や法令違反による損失抑制になる

AIガバナンスが急務なのに、なぜ企業は導入に踏み切れないのか?

AIの監視やリスク管理の仕組み、まあ重要だと言われているけれど、現場で本格的に導入している会社はそこまで多くない印象がある。何が壁になってるのか、そのあたりはっきりしない部分もありそう。Principal Financial Groupの場合、ここ数年でAIの活用例がかなり増えてきたみたいで、それにつれて包括的なガバナンスを考えざるを得なくなったらしい。

なんとなく七十以上とも言われる色々なAI案件——自然言語系だったり、機械学習とか生成系AIも絡めて詐欺対策や保険金処理の自動化、投資調査、それから年金プランの最適化やコンタクトセンターの支援まで、多岐にわたっていると担当役員のラジェシュ・アローラ氏が語っていた気がする。ただ、その一つ一つに規制対応とかバイアスへの配慮、倫理上の懸念など新たなリスクも付きまとう。

そんな背景で最初に作った枠組みが「倫理的かつ責任あるAI(ERAI)」という方針で、流れとしては案件受付からリスク分類、モデル検証、それ以降も定期チェックを続ける——こんな感じで全体を見渡すものらしい。このフレームワークには説明可能性、人による監督、それとプライバシー保護なども含まれていて、一応どんなAIにも当てはめることになっているそうだ。

しばらくして今度はCredo AIというツールも入れてみて、全部のAI案件を棚卸ししたり、リスク評価・データプライバシー・法令遵守状況などを追いかけたりできるようになったっぽい。規制や基準への整合性確認にも使えるんだろうか。それとServiceNowでも何かガバナンス関連のワークフローを試験運用している、と本人は話していた記憶がある。どこまで進んでいるかは分からないけど、一部ではこういう取り組みが静かに進行中みたいだ。

なんとなく七十以上とも言われる色々なAI案件——自然言語系だったり、機械学習とか生成系AIも絡めて詐欺対策や保険金処理の自動化、投資調査、それから年金プランの最適化やコンタクトセンターの支援まで、多岐にわたっていると担当役員のラジェシュ・アローラ氏が語っていた気がする。ただ、その一つ一つに規制対応とかバイアスへの配慮、倫理上の懸念など新たなリスクも付きまとう。

そんな背景で最初に作った枠組みが「倫理的かつ責任あるAI(ERAI)」という方針で、流れとしては案件受付からリスク分類、モデル検証、それ以降も定期チェックを続ける——こんな感じで全体を見渡すものらしい。このフレームワークには説明可能性、人による監督、それとプライバシー保護なども含まれていて、一応どんなAIにも当てはめることになっているそうだ。

しばらくして今度はCredo AIというツールも入れてみて、全部のAI案件を棚卸ししたり、リスク評価・データプライバシー・法令遵守状況などを追いかけたりできるようになったっぽい。規制や基準への整合性確認にも使えるんだろうか。それとServiceNowでも何かガバナンス関連のワークフローを試験運用している、と本人は話していた記憶がある。どこまで進んでいるかは分からないけど、一部ではこういう取り組みが静かに進行中みたいだ。

Principal Financial Groupが100以上のAIユースケースで直面した現実

プリンシパル・ファイナンシャル・グループのデータ&アナリティクス担当であるラジェシュ・アローラ氏や、ガートナーでアナリストを務めるアヴィヴァ・リタン氏など、いくつかの専門家はAIのリスクについて話していた。たとえば、データの漏洩とか誤情報が混じった出力、それから意図しない結果がAIから返ってきたりすることで、判断を間違う危険性が大きいという指摘もあったりするようだ。生成系AIになると特にその傾向が強まるらしい。

EYで責任あるAI領域を見ているシンクレア・シュラー氏も「AIガバナンスって企業にはかなり重要なものになりつつある」と言っていた。もしこの辺りの管理体制がうまくいかない場合、その会社自体にも大きな影響が出る可能性もありそうだ。とはいえ、この分野への取り組みは想像より広まっているとは言えず、そこまで一気に普及している感じでもない。

Gartnerでは近い将来(数年後くらい?)にAIガバナンス関連のプラットフォームが事業戦略上かなり注目される流れになると予想していて、この種のツールを導入した企業では倫理的な問題とかトラブルが七割ほど減る傾向も見込まれている。でも現時点では、実際こうした製品や仕組みが積極的に使われている訳じゃなく、その理由としては技術側の完成度以外にも色々事情が絡むみたい。「CIOたちは投資対効果を見出しづらくて、新しいツールにはなかなか手を出しにくい状況」という声もちらほら聞こえる。

全体として、必要性は徐々に認識されつつあるけど、一部では導入ペースは緩やかと言わざるを得ない場面も多い印象だ。

EYで責任あるAI領域を見ているシンクレア・シュラー氏も「AIガバナンスって企業にはかなり重要なものになりつつある」と言っていた。もしこの辺りの管理体制がうまくいかない場合、その会社自体にも大きな影響が出る可能性もありそうだ。とはいえ、この分野への取り組みは想像より広まっているとは言えず、そこまで一気に普及している感じでもない。

Gartnerでは近い将来(数年後くらい?)にAIガバナンス関連のプラットフォームが事業戦略上かなり注目される流れになると予想していて、この種のツールを導入した企業では倫理的な問題とかトラブルが七割ほど減る傾向も見込まれている。でも現時点では、実際こうした製品や仕組みが積極的に使われている訳じゃなく、その理由としては技術側の完成度以外にも色々事情が絡むみたい。「CIOたちは投資対効果を見出しづらくて、新しいツールにはなかなか手を出しにくい状況」という声もちらほら聞こえる。

全体として、必要性は徐々に認識されつつあるけど、一部では導入ペースは緩やかと言わざるを得ない場面も多い印象だ。

生成AIの暴走リスクが引き起こす「会社ごと崩壊」の悪夢

最近になってようやく、リスク管理とかセキュリティみたいな話題が少しずつ注目され始めた気がする。ウェブスター銀行のCIOであるヴィクラム・ナフデ氏も、今のところAIガバナンス専用のプラットフォームを導入したというわけではないらしい。どうやら銀行内では生成AIをいろんな業務に活用しているそうで、書類の処理とか、まとまっていないデータへの対応、それからピアレビューっぽい信用審査まで幅広く使われているという。内部用のガイドラインも作成されていて、AI利用に関するポリシーや監督委員会みたいなのも出来ているみたい。でも現状はJiraとかSharePoint、それとServiceNowなど既存のエンタープライズ向けツールを組み合わせて、ワークフローや管理手続きの証跡管理なんかを分担させてる感じだ、と彼は言っていた。

ただ、このままでは不便らしく、「法務やリスク部門、それからデータ・セキュリティ関連とも連動できる、一体型っぽいプラットフォームがあればいいんだけど」と検討中とのこと。一方で、自律的に判断して動くタイプのエージェントAIが普及してくると(今後二年ぐらいで一気に増えるかもしれない)、今まで通り手作業ベースで全体を制御する方法には限界が見えてきそうだ、と別の専門家も指摘していた。この種のAIは思った以上に予測しづらかったり、ちょっとしたことで意図せぬ方向へ行ってしまうことがあるので、何かしら制御策が求められる場面も出てきそう――まあ全部自動化すれば安心とは言えないものの、多くの場合、人間によるチェックだけでは追いつかなくなる可能性も考えられる。実際どこまで必要になるかは、その時々次第になるかもしれないけど。

ただ、このままでは不便らしく、「法務やリスク部門、それからデータ・セキュリティ関連とも連動できる、一体型っぽいプラットフォームがあればいいんだけど」と検討中とのこと。一方で、自律的に判断して動くタイプのエージェントAIが普及してくると(今後二年ぐらいで一気に増えるかもしれない)、今まで通り手作業ベースで全体を制御する方法には限界が見えてきそうだ、と別の専門家も指摘していた。この種のAIは思った以上に予測しづらかったり、ちょっとしたことで意図せぬ方向へ行ってしまうことがあるので、何かしら制御策が求められる場面も出てきそう――まあ全部自動化すれば安心とは言えないものの、多くの場合、人間によるチェックだけでは追いつかなくなる可能性も考えられる。実際どこまで必要になるかは、その時々次第になるかもしれないけど。

JiraやServiceNowで間に合わせる銀行の苦肉の策

「なんだか世間でAIはすごく話題になっているけど、現場では導入が進んでいるとは言い切れないよね」と彼女はぼそっと言ったりすることがある。まあ一般的な普及までは、あと何年かはかかるんじゃないかなという見方もちらほらあって、それこそガートナーの言う“生産性の安定期”に到達するには、まだもう少し時間が必要なのかもしれない。

ところでCIO向けのAIガバナンス用プラットフォームについてだけど、Lisa Palmer氏(Dr. Lisa AIというコンサル会社の代表でCAIOも兼任)によれば、モデル監視やバイアス発見とかポリシー管理、それからコンプライアンスチェックをちょっと簡素化できるツールも増えてきているっぽい。なんでも、その手の仕組みを使えば、公平性とか偏りへの目配せもしやすくなるそうだし、特徴量の寄与度やヒートマップなど説明性を補助する機能も盛り込まれているケースが多いみたい。でも実際にはリアルタイムでモデル性能やドリフト・法規対応状況まで追えるものも出てきていて、そのへんを彼女自身が書いたCIO向けガイドブックでも触れていた気がする。

またFiddlerとかTruEra、それとCredo AIみたいなサービスなら、説明性不足のポイントやデータ系統を可視化したり、本番環境下でモデル挙動がちゃんとしてるかどうか追跡しやすくなる、とLisa Palmer氏はコメントしてた。ただ、こうした道具立てだけじゃ人間側の判断力まではカバーできないし、ビジネス価値そのものを定義してくれるわけでもなくて……AI案件と経営戦略との結びつきを自動的に測れるような万能さは今のところ期待薄かなという声もちらほら。

ところでCIO向けのAIガバナンス用プラットフォームについてだけど、Lisa Palmer氏(Dr. Lisa AIというコンサル会社の代表でCAIOも兼任)によれば、モデル監視やバイアス発見とかポリシー管理、それからコンプライアンスチェックをちょっと簡素化できるツールも増えてきているっぽい。なんでも、その手の仕組みを使えば、公平性とか偏りへの目配せもしやすくなるそうだし、特徴量の寄与度やヒートマップなど説明性を補助する機能も盛り込まれているケースが多いみたい。でも実際にはリアルタイムでモデル性能やドリフト・法規対応状況まで追えるものも出てきていて、そのへんを彼女自身が書いたCIO向けガイドブックでも触れていた気がする。

またFiddlerとかTruEra、それとCredo AIみたいなサービスなら、説明性不足のポイントやデータ系統を可視化したり、本番環境下でモデル挙動がちゃんとしてるかどうか追跡しやすくなる、とLisa Palmer氏はコメントしてた。ただ、こうした道具立てだけじゃ人間側の判断力まではカバーできないし、ビジネス価値そのものを定義してくれるわけでもなくて……AI案件と経営戦略との結びつきを自動的に測れるような万能さは今のところ期待薄かなという声もちらほら。

AIガバナンスツール市場がまだ混沌としている本当の理由

AIガバナンスのプラットフォーム市場には、ざっと数十社ほどベンダーがひしめいているらしい。Litan氏によれば、普及率はまだそれほど高くないので、参考になる導入事例なんかもあまり見当たらない。そのためか、Gartnerでもリーダーや遅れを取ってる企業を明確に分類したレポートみたいなものは今のところ出ていないという話も聞く。ただ、それぞれ得意分野を持っている会社はいくつか見つかるみたいだ。例えばZenityはMicrosoft製品――365 Copilotとかそのあたり――の監視で強みを持っていると言われていたり、Craniumは外部委託先のリスク管理がわりと得意だとされることがある。他にもNoma Securityだとインフラやランタイム違反に目ざとい印象で、Holisticはバイアス検証にそこそこ実績があるようだ。

AIガバナンス用のツール自体も色々な用途で使えるみたい。例えばChatGPTやAnthropicみたいな外部AIサービスを社内でどう利用するか、その利用ルールを定めたり運用したりする時にも役立つことがあるし、自前で新しいAI資産を設計・開発する際にも同じような仕組みが応用できるケースもある。「こういうツールなら方針を書き下ろして、それに沿った運用までカバーできる」とSchuller氏もどこかで語っていた気がする。

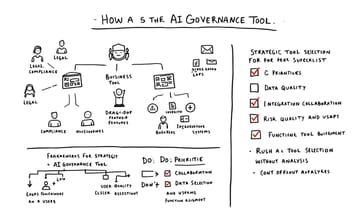

でもね、実際にAIガバナンス系のソフトを選ぶ時には、その前段階としてCIOたちがやっておくべき準備作業が色々あるらしい。まず手始めに社内で稼働しているAIアプリケーションの棚卸し――要はどんなものをどこでどう使っているか洗い出しておく必要がありそうだ。それから「うちでは何を解決したいんだっけ」「ガバナンス結果について誰が責任持つ?」「現行ルールやワークフロー、それともこれから作る?」…そんな問いへの答えもぼんやりさせず考えておかなきゃダメ、とPalmer氏は指摘する。「この辺り曖昧なままだと、高機能なツールでも期待通りには働いてくれない」らしい。だから最初はユースケースごとの洗い出しとか、リスク水準についてざっくり評価しておくところから始めた方がいいんじゃないかなと思う。

AIガバナンス用のツール自体も色々な用途で使えるみたい。例えばChatGPTやAnthropicみたいな外部AIサービスを社内でどう利用するか、その利用ルールを定めたり運用したりする時にも役立つことがあるし、自前で新しいAI資産を設計・開発する際にも同じような仕組みが応用できるケースもある。「こういうツールなら方針を書き下ろして、それに沿った運用までカバーできる」とSchuller氏もどこかで語っていた気がする。

でもね、実際にAIガバナンス系のソフトを選ぶ時には、その前段階としてCIOたちがやっておくべき準備作業が色々あるらしい。まず手始めに社内で稼働しているAIアプリケーションの棚卸し――要はどんなものをどこでどう使っているか洗い出しておく必要がありそうだ。それから「うちでは何を解決したいんだっけ」「ガバナンス結果について誰が責任持つ?」「現行ルールやワークフロー、それともこれから作る?」…そんな問いへの答えもぼんやりさせず考えておかなきゃダメ、とPalmer氏は指摘する。「この辺り曖昧なままだと、高機能なツールでも期待通りには働いてくれない」らしい。だから最初はユースケースごとの洗い出しとか、リスク水準についてざっくり評価しておくところから始めた方がいいんじゃないかなと思う。

ツール選びで絶対外せない5つのチェックポイント

初期の組織だと、最近ちょっと話題になってきたMLOpsのプラットフォームなんかが役立つ場面もあるみたい。ただ、もうそこそこ成熟してるところでは、ポリシーを自動で適用したり、バイアスの監査を機械的にやってくれる仕組みが求められる場合も多いという声がある。ガートナーのアナリストであるAvivah Litan氏は「まずは整理整頓から始めてほしい」と言っていた気がする。AIに対する責任とか、その辺のルールを先に考えておくこと。AIがどこでどう使われているか一通り把握しないといけないし、誰が何を利用しているかも可能な範囲で掴んでおきたいところ。リスクについてもざっくりでもいいから感じ取っておいて損はなさそう。それから、データそのものについてだけど…まあ、権限管理とか分類付けとか、それなりに厳しく見る必要がありそうだし、一度ロックダウンしてみるのも手かもしれない。

道具選びになると、CIOたちはモデル説明性とか偏り検知、それからルールベースの自動化・コンプライアンス対応まで意識したほうが後々ラクだろうとPalmerさんは話していたような…。リアルタイムでモデル性能を見る仕組みや、規制当局からチェックされても困らない程度には監査証跡やドキュメントを残せる機能なんかも大事だと言われてる。あと既存の開発プロセスとうまく繋げられるかどうか――この点を見落とす企業、多い気がする。Schuller氏によれば、「最初から選定基準をある程度決めておいて、その基準でベンダーとすり合わせしていく方がいい」と教えていた記憶もあるし、自分たちの理想的なガバナンス体制ってどんな感じなのか、おぼろげでも描いておいた方が後悔しづらいという話だった気がする。

ただ、実際には色んな現場事情や予算都合など絡むので、一概にこうすべきとは言えない部分も多いだろう。

道具選びになると、CIOたちはモデル説明性とか偏り検知、それからルールベースの自動化・コンプライアンス対応まで意識したほうが後々ラクだろうとPalmerさんは話していたような…。リアルタイムでモデル性能を見る仕組みや、規制当局からチェックされても困らない程度には監査証跡やドキュメントを残せる機能なんかも大事だと言われてる。あと既存の開発プロセスとうまく繋げられるかどうか――この点を見落とす企業、多い気がする。Schuller氏によれば、「最初から選定基準をある程度決めておいて、その基準でベンダーとすり合わせしていく方がいい」と教えていた記憶もあるし、自分たちの理想的なガバナンス体制ってどんな感じなのか、おぼろげでも描いておいた方が後悔しづらいという話だった気がする。

ただ、実際には色んな現場事情や予算都合など絡むので、一概にこうすべきとは言えない部分も多いだろう。

「ポリシー継承機能」が大規模展開の鍵だと専門家が指摘

プラットフォームを選ぶとき、もしその機能がどうしても捕まえられないなら、まあ…たいてい除外したほうがいいかもしれない、と誰かが言っていたような気がする。ガバナンスポリシーというものについて考えると、全体のルールみたいなやつを設定して、それに従う形で小さめの規則(サブポリシー?)を何層にも重ねていける仕組み――これは結構便利らしい。分野とか事業部門ごとに違いはあっても、基本線だけは守れるし。ただ、その辺りは人によって見方が異なるだろう。

ナフデさんも確か似たような意見だったかもしれない。ガバナンスを管理する立場からすると、複数領域に渡る場合にはこういう機能が役に立つ可能性はある、と話していたような。全部一律じゃ息苦しいけど、土台だけ決めて後は柔軟に調整できれば…まあ組織としてもうまく進むことも多そう。でもイノベーションのスピード感までは完全に失わず済む――この「完全」って表現もちょっと強すぎるかな、失われにくいぐらいかな。

とは言え結局、人間の判断抜きでは済まされないところも残るらしい。シュラー氏によれば、「途中でちょこちょこ確認ポイント作って、人の目で承認したりダメ出ししたりするべきだ」と語っていた記憶がある。最終的にはやっぱり人間側が舵取りしなきゃいけない部分はあるっぽい。

それからパルマーさんという人も何か指摘していたと思う。基準として大事なのは統合の深さとか、多様な担当者でも使いやすいこと、それとモデルや規制への対応力なんかも評価材料になるんじゃないかな、と話していた気がする。一度聞いただけだから細部は曖昧だけど…。

ナフデさんも確か似たような意見だったかもしれない。ガバナンスを管理する立場からすると、複数領域に渡る場合にはこういう機能が役に立つ可能性はある、と話していたような。全部一律じゃ息苦しいけど、土台だけ決めて後は柔軟に調整できれば…まあ組織としてもうまく進むことも多そう。でもイノベーションのスピード感までは完全に失わず済む――この「完全」って表現もちょっと強すぎるかな、失われにくいぐらいかな。

とは言え結局、人間の判断抜きでは済まされないところも残るらしい。シュラー氏によれば、「途中でちょこちょこ確認ポイント作って、人の目で承認したりダメ出ししたりするべきだ」と語っていた記憶がある。最終的にはやっぱり人間側が舵取りしなきゃいけない部分はあるっぽい。

それからパルマーさんという人も何か指摘していたと思う。基準として大事なのは統合の深さとか、多様な担当者でも使いやすいこと、それとモデルや規制への対応力なんかも評価材料になるんじゃないかな、と話していた気がする。一度聞いただけだから細部は曖昧だけど…。

ツール導入前に絶対やっておくべき3つの準備作業

ガバナンスツールって、AIの管理だけじゃなくて、法務とかコンプライアンス、それにビジネス関係者まで巻き込むから、いろんな部署が一緒にアクセスできるのはまあ当然求められてくるわけで。どこかの会社だと、使いやすさや柔軟性、それと拡張できる感じも大切だったようだし、ツール自体が運用方法の変化にある程度ついていけないと困ると言われたこともあったかな。パフォーマンスとかコスト面(そうね、十倍まではいかなくても地味に効いてくる)もしっかり見ていたみたい。

でも実際には、ツールを色々調べているうちに、組織ごとの複雑なAI活用場面――曖昧な判断求められる時なんかは、多くの製品が思ったより上手く動かないケースが目についた、と話していた人もいた気がする。現場に馴染ませたりスタッフ向けトレーニングしたりすると結構時間食うことも珍しくない。既存システムとうまく繋げる部分も案外簡単じゃなくて、「完璧!」とは言いづらい状況になりやすかった印象。

それだけじゃなくて――例えばデータ品質や正確性、それと抜け漏れみたいな基本的な問題への対応となると、多くのツールはまだ十分とは言えず、「課題多いよね」という声もちょっと聞こえてきたんだよね。

今後どうする?というところで、「AIガバナンス用のプラットフォーム持っておきたい」気持ちは分かるんだけど……専門家によれば「まず枠組みとか進め方を固めてから道具選び始めたほうがいい」と言われていた記憶もある。「自社で何をどれくらいやっているか」「リスクってどんなもの?」――この辺ちゃんと把握した上で、その次として本当に必要な機能や使いやすさを見極めながら検討進めたほうが無難なのかな……そんな流れだったと思う。

でも実際には、ツールを色々調べているうちに、組織ごとの複雑なAI活用場面――曖昧な判断求められる時なんかは、多くの製品が思ったより上手く動かないケースが目についた、と話していた人もいた気がする。現場に馴染ませたりスタッフ向けトレーニングしたりすると結構時間食うことも珍しくない。既存システムとうまく繋げる部分も案外簡単じゃなくて、「完璧!」とは言いづらい状況になりやすかった印象。

それだけじゃなくて――例えばデータ品質や正確性、それと抜け漏れみたいな基本的な問題への対応となると、多くのツールはまだ十分とは言えず、「課題多いよね」という声もちょっと聞こえてきたんだよね。

今後どうする?というところで、「AIガバナンス用のプラットフォーム持っておきたい」気持ちは分かるんだけど……専門家によれば「まず枠組みとか進め方を固めてから道具選び始めたほうがいい」と言われていた記憶もある。「自社で何をどれくらいやっているか」「リスクってどんなもの?」――この辺ちゃんと把握した上で、その次として本当に必要な機能や使いやすさを見極めながら検討進めたほうが無難なのかな……そんな流れだったと思う。

ベンダーとの値引き交渉が成立する意外な事情

業者によっては、値段交渉にそこそこ柔軟な対応をしてくれることもあるらしい。まだ分野自体が始まってから日が浅いせいか、話によればどこかで割引に応じるケースも見られるようだ。ただし、単純にツール本体の購入費用だけで済むわけじゃないという声もある。実際には導入後の人手や時間、それからリソース面で思ったより負担が大きくなると指摘する人もいて、組織内で誰が担当になるのかすら曖昧なまま進んでしまう場面も珍しくないみたい。

AIガバナンス用のツールにはモニタリング機能などそれなりに役立つ部分はあるものの、一方ではCIOが自社における「受け入れ可能なリスク」とは何なのか考えておく必要が出てくる。AI関連施策を会社全体のビジネス目標とどう結び付けるかとか、統一した管理戦略を作る作業なんかも結局避けて通れない、と何人か専門家は言及していた。こういうプラットフォーム自体はガバナンス戦略そのものを決めてくれるわけじゃなくて、多くの場合外部からの脅威──例えばAI絡みの世論操作っぽい活動とか、大勢による同時クレーム、ブランドイメージ操作みたいな話──まで完全にはカバーしきれていない印象も残る。それについて「見落としやすいポイントだから注意した方がいい」と言う意見もあった。

逆に運用開始後になってくると、今度は規定やルール設定を厳しすぎないよう気を付けたほうがいいというアドバイスも耳にすることがある。「AIって意外と創造的な側面持ってますよね」なんて発言もちょっと前に聞いた覚えがあって、その辺り加減次第で効果にも差が出そうだ。

AIガバナンス用のツールにはモニタリング機能などそれなりに役立つ部分はあるものの、一方ではCIOが自社における「受け入れ可能なリスク」とは何なのか考えておく必要が出てくる。AI関連施策を会社全体のビジネス目標とどう結び付けるかとか、統一した管理戦略を作る作業なんかも結局避けて通れない、と何人か専門家は言及していた。こういうプラットフォーム自体はガバナンス戦略そのものを決めてくれるわけじゃなくて、多くの場合外部からの脅威──例えばAI絡みの世論操作っぽい活動とか、大勢による同時クレーム、ブランドイメージ操作みたいな話──まで完全にはカバーしきれていない印象も残る。それについて「見落としやすいポイントだから注意した方がいい」と言う意見もあった。

逆に運用開始後になってくると、今度は規定やルール設定を厳しすぎないよう気を付けたほうがいいというアドバイスも耳にすることがある。「AIって意外と創造的な側面持ってますよね」なんて発言もちょっと前に聞いた覚えがあって、その辺り加減次第で効果にも差が出そうだ。

創造性を殺さずにAIを制御するバランス感覚

AIの管理って、ある程度縛りは必要だけど、ガチガチにしすぎると創造性が出てこなくなる気がする——そんな話をしていたら、アローラ氏も似たようなことを指摘していた。業界全体で責任あるAIとかセキュリティの方針がまだ成熟しきれていない感じで、そのあたりが曖昧だとAIガバナンスのプラットフォーム自体も十分な効果を発揮しきれないかもしれない、と。基礎となる枠組みが緩いままだと、せっかく導入したツールも本来の力が出せない…という見方は一定の説得力があるように思う。

だからなのか、「AIガバナンスを単なるコンプライアンス対応じゃなくて、一種のビジネス能力として捉えたほうがいいんじゃないかな」とアローラ氏はアドバイスしている。組織ごとに構造や事情も違うから、柔軟にフィットできつつ、でもルールとしてはそこそこ一貫性を保てるツール選びが大事みたいだ。ただ、この領域自体ここ数年で大きく様変わりしていて、政策や仕組みもどんどん書き換わっている印象。

シュラー氏によれば、一度何かしらのガバナンス基盤を作ってしまった後でも、それっきり放置は危ういとのこと。むしろ定期的にチェックするぐらいでちょうどよくて、大げさに言えば「毎月」や「四半期ごと」くらいの短めサイクルでポリシー見直すくらいでも悪くなさそう、と語っていた(まあ実際には少し幅があるだろうけれど)。

…ところで、そのニュースレターへの登録案内みたいなものもちょこっと挟まっていたようだけど、本筋とは少しずれている気もしなくはない。

だからなのか、「AIガバナンスを単なるコンプライアンス対応じゃなくて、一種のビジネス能力として捉えたほうがいいんじゃないかな」とアローラ氏はアドバイスしている。組織ごとに構造や事情も違うから、柔軟にフィットできつつ、でもルールとしてはそこそこ一貫性を保てるツール選びが大事みたいだ。ただ、この領域自体ここ数年で大きく様変わりしていて、政策や仕組みもどんどん書き換わっている印象。

シュラー氏によれば、一度何かしらのガバナンス基盤を作ってしまった後でも、それっきり放置は危ういとのこと。むしろ定期的にチェックするぐらいでちょうどよくて、大げさに言えば「毎月」や「四半期ごと」くらいの短めサイクルでポリシー見直すくらいでも悪くなさそう、と語っていた(まあ実際には少し幅があるだろうけれど)。

…ところで、そのニュースレターへの登録案内みたいなものもちょこっと挟まっていたようだけど、本筋とは少しずれている気もしなくはない。