最近很多人在聊 Perplexity AI。嗯...這東西,說真的,我一直在想它到底算什麼。是一個更聰明的 Google,還是一個...只是看起來很會引經據典的聊天機器人?

重點一句話

我自己是覺得,它像一個速度超快、很會找資料,但偶爾會自己腦補、理解錯重點的實習生。你不能把它丟著不管,還是得親自盯著,不然會出事。

所以它到底厲害在哪?

好,它最常被拿出來講的,就是會給「來源」。這點...沒錯,真的很重要。你問它問題,它給你一段答案,旁邊會跟著一些小小的數字 [1]、[2] 這樣。點下去,就可以看到它這句話是從哪個網站看來的。

這就解決了一個大問題:透明度。不像有些 AI,答案像是從空氣中變出來的,你根本不知道它哪來的自信。Perplexity 至少把它的「參考書目」列給你看。這等於是強迫你去想...「喔,這個資訊是從哪來的?」這個小習慣,在這個時代,很重要。

再來是即時連網。這點也很關鍵。很多 AI 模型用的資料都是幾個月、甚至一年前的。你要查昨天才發生的新聞,它就幫不上忙。Perplexity 號稱是直接上網撈最新的資料。對於查證一些正在發酵的事件,理論上...對,我是說理論上,會比較有幫助。

實際用起來...感覺有點微妙

紙上談兵看起來都很好。但實際打開來用...那個感覺,真的有點微妙。

問題出在「摘要」跟「來源」之間的關係。它會給你一段看起來很通順的總結,然後附上來源。但...你如果真的點進去看那個來源,有時候會發現,AI 的摘要跟原文的意思...嗯,有那麼一點點偏差。

它可能抓到了關鍵字,但沒搞懂上下文的語氣。我真的碰過,它把一篇報導裡「質疑某個說法」的段落,摘要成「證實了這個說法」。你想想,這有多危險。特別是當你很忙,只想看摘要的時候,就很容易被誤導。

還有啊,對在地議題的掌握度也是個問題。比如說,我之前試著用它查一些台灣的法規或政策。它給的答案...有時候會引用到一些內容農場,或是好幾年前的舊聞。它沒辦法像「台灣事實查核中心」那樣,有那麼深的在地知識跟脈絡。這不是它的錯,這是模型的限制。它對美國發生的事,顯然比對台灣的了解得多。這點在用的時候,心裡要有個底。

那...怎麼用它來「練習」查資料?

所以用了幾次之後,我自己摸索出一個比較...嗯,比較安全的使用方式。我不把它當作「答案提供者」,而是「議題起點產生器」。

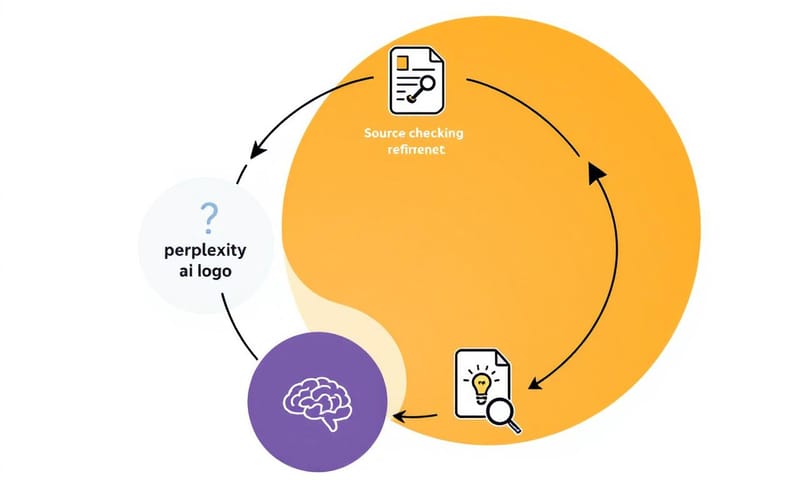

我的步驟大概是這樣:

丟一個初步的問題:不用太精確,就是把我想知道的大方向丟給它。

看它回了什麼:但我的重點不是看它寫的「摘要」,而是看它找了「哪些來源」、用了「哪些關鍵字」。

直接點進來源自己讀:這才是重點。我會自己打開那三、五個來源網站,快速掃過一遍。自己判斷這些來源的可信度,自己理解原文的脈絡。

回來修正問題再問一次:看完原始資料後,我對問題的理解更深了。這時可以問一個更精確、更深入的問題。然後重複上面的循環。

簡單講,就是讓 Perplexity 幫我做第一輪的「大海撈針」,幫我從茫茫網路中,撈出幾個可能相關的連結。但真正的「閱讀」跟「判斷」,還是得自己來。這方法雖然慢一點,但比較不會被 AI 牽著鼻子走。

比較一下好了,傳統查資料 vs. 用 Perplexity

為了更清楚,我把它跟我自己以前土法煉鋼的方式做了個比較。感覺就像這樣。

| 傳統查資料 (Google + 自己讀) | 依賴 Perplexity 摘要 | |

|---|---|---|

| 速度 | 很慢。要自己開一堆分頁,然後一個個看。 | 超快。幾秒鐘答案就出來了,看起來還整理得很好。 |

| 準確度 | 看個人功力。但至少...你知道自己是怎麼得出結論的。掌控權在自己手上。 | 不穩定。可能是 90 分,也可能是 50 分還包裝成 90 分的樣子。這最可怕。 |

| 心力消耗 | 很累。大腦要一直運轉,比對資訊、判斷真偽。 | 感覺很輕鬆...但這是假象。因為你放棄了思考,所以大腦很省力。長期下來,判斷力可能會退化。 |

| 最大優點 | 能訓練獨立思考跟媒體識讀能力。過程本身就是一種學習。 | 效率。處理大量、不那麼關鍵的資訊時,可以省下很多時間。 |

| 最大風險 | 可能永遠找不到想要的資料,或是被太多資訊淹沒。 | 不自覺地就信了它的話,還以為自己查證過了。這就是所謂的「外包思考」。 |

好,但危險的地方在這裡

說到底,Perplexity 最大的風險,不是「它會犯錯」。任何工具都會。最大的風險是「它犯錯時,看起來依然非常權威」。

你想想,它有條理分明的格式、看起來很專業的引文、通順的文筆...這一切都在暗示你「我是可信的」。這種由 GPT-4 或 Claude 3 這類大型語言模型生成的流暢文字,本身就帶有一種說服力。當這種說服力跟錯誤的資訊結合在一起,就是最完美的認知陷阱。

這就是大家說的「AI 幻覺」(AI Hallucination),但它現在不只是胡言亂語,而是穿上了學術外袍的幻覺。這更難防。

所以,你的大腦還是最後一道、也是最重要的一道防線。那種「嗯?這裡感覺怪怪的」的直覺,比任何 AI 功能都還重要。

常見的誤解與修正

圍繞著這個工具,我看到一些蠻常見的誤解。我自己是這樣看的:

誤解一:「有引文就代表百分之百正確。」

我的想法:這大概是最大的迷思。引文只代表 AI「參考」了那篇文章,不代表它「讀懂」了。一定要養成習慣,至少抽查幾個關鍵的引文,回去核對原文到底是不是那個意思。誤解二:「它可以完全取代 Google 搜尋了。」

我的想法:我覺得不行。它們是兩種不同的工具。Google 給你的是一堆「路徑」,讓你親自走進去看。Perplexity 給你的是「它走完之後寫的報告」。有時候你需要看路上的風景,而不只是聽別人的報告,對吧?誤解三:「我付錢用 Pro 版,答案就會更準確。」

我的想法:嗯...不完全是。Pro 版的模型(像 GPT-4 Omni 或 Claude 3 Opus)可能更強大,能理解更複雜的問題,或是每天可以問更多次。但 AI 模型的核心限制...就是我們前面講的那些,幻覺、誤解上下文...這些問題依然存在,只是發生的機率可能低一點。它不是一個「準確度」的開關。

總之,把它當成一個強化的工具,而不是一個可以完全信賴的大腦。你的懷疑、你的批判性思考,才是你最有價值的東西。別輕易把它外包出去。

聊了這麼多,換你說說看:你覺得像 Perplexity 這樣的工具,最大的幫助是什麼?或者,你最擔心它帶來的問題又是什麼?在下面分享你的看法吧。