你有沒有過這種經驗,用 ChatGPT 或類似的 AI,問了一個超攏統的問題,結果它給你的答案...嗯...簡直就像住在你腦子裡一樣?好像它完全知道你想幹嘛,甚至比你自己還清楚。這真的蠻詭異的,對吧。

我最近一直在想這件事。一台電腦,一堆程式碼,怎麼可能做到像在「讀心」一樣?今天就來聊聊這個,掀開這塊布,看看背後到底是什麼魔法。老實說,它的原理...可能跟你想的完全不一樣。

重點一句話

AI 不是在「讀懂」你的想法,它只是個超級無敵厲害的「文字接龍」大師,厲害到讓你以為它有智慧。

所以,大型語言模型 (LLM) 到底是什麼鬼?

好,我們常常聽到大家在講什麼「大型語言模型」,LLM...聽起來很高科技,但簡單講,它就是一個超級強化的文字預測機器。但如果只說它是文字預測,又有點太小看它了。這大概就像說 iPhone 只是個計算機一樣,嗯...技術上沒錯,但完全沒抓到重點。

你可以把它想像成一個數位海綿,把整個網路上大部分的文字都吸乾了。書、文章、維基百科、PTT 廢文、程式碼...它全都「讀」過。然後,它用這些吸收來的海量知識,去生成看起來很像真人會說的話。

但這裡才是最扯的地方:這些模型不只是死背文字。它在讀這麼多東西的過程中,居然自己學會了文字之間的模式、關係,甚至是某種程度上的...嗯...推理能力。這就像讓一個人擁有全世界所有對話的記憶,然後把他拉進你的聊天群組裡。很可怕吧。

這規模...大到有點不真實

當我說「大型」的時候,我指的不是普通的大,是真的大到很誇張。一個模型檔案的大小可能是幾十 GB 起跳。

你知道嗎,光是 GPT-3 這個比較早期的模型,就用了 45TB 的文字資料去訓練,然後內部有 1750 億個「參數」。一千七百多億...這數字到底是什麼概念?我真的無法想像。這比一個人一輩子...不,好幾輩子能讀完的文字都還要多太多了。

說到這個,突然想到我人生第一台電腦的記憶體好像是 64MB 吧,那時候還覺得超屌超夠用。如果把現在這些 AI 模型丟到那個時代,我的小電腦大概會直接冒煙給你看。時代真的變了啊。

那它的大腦是怎麼運作的啊?

OK,我知道上面講的有點抽象。我們來拆解一下,一個 LLM 的運作基本上就靠三樣東西:資料、架構、跟訓練。我盡量用白話講。

首先是它的「飲食」。你要讓這隻怪獸長大,就是要瘋狂餵它吃東西,也就是文字資料。書本、新聞、學術論文、社群網站的貼文...對,連你半夜三點有感而發的那些廢文,可能都在它的菜單上。而且食物的多樣性很重要,你不能只餵它愛情小說,然後期待它懂量子物理,對吧?

再來是它大腦的結構,這部分技術上叫做「Transformer 架構」。你不用管這個名字,聽起來很像變形金剛。你只要把它想像成一個超級精密的「模式比對器」就好了。當你打出「天空是...」,它不是只看這三個字,它會去思考這三個字跟它腦中所有學過的字,彼此之間所有可能的關聯性。它會去猜,根據它讀過的上億個句子,「天空是」後面最可能接什麼字。一開始它可能會猜「漢堡」,真的,早期的 AI 就是這麼笨。但每次猜錯,它就會微調內部那幾千億個參數,讓自己下次猜得更準一點。玩個幾百萬幾千萬次這種猜詞遊戲之後,它慢慢就學會了,「天空是藍色的」機率遠大於「天空是漢堡」。

整個過程就像一個超級沒耐心的魔鬼教練在帶數位新兵,答錯就修正,重複到天荒地老,直到它變成一個語言大師為止。

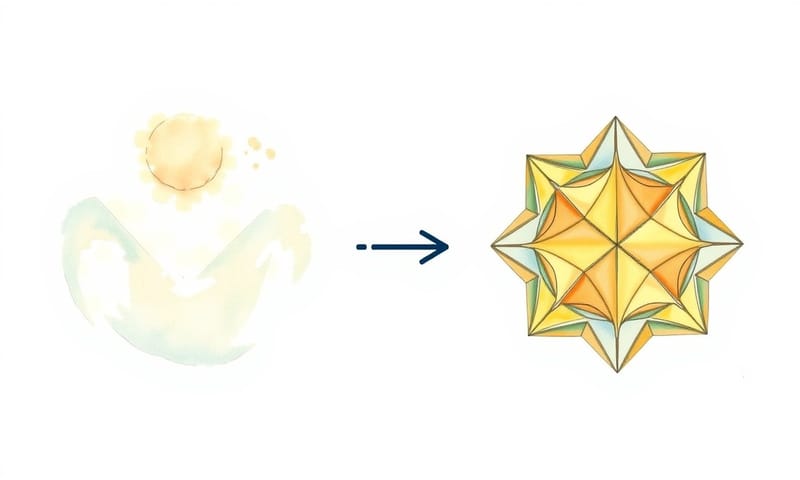

AI 其實也有分「通才」跟「專才」

這是一個很多人不知道的秘密。那些 LLM 在經過前面說的「海量閱讀」基礎訓練後,其實還會被送去唸「研究所」,這個過程叫做「微調」(Fine-tuning)。

一個剛訓練好的通用模型,可能什麼都懂一點,但什麼都不精。但透過微調,你可以把它變成某個領域的專家。這也是為什麼你覺得某些 AI 在寫詩、寫程式碼的時候特別強,但在問它昨天樂透開幾號時就開始胡說八道。因為它被「特訓」過。這點我覺得超重要,因為它解釋了為什麼不同家的 AI 會有不同的「個性」。

| 比較項目 | 通用大型語言模型 (General LLM) | 微調後的大型語言模型 (Fine-tuned LLM) |

|---|---|---|

| 好比說... | 一個剛大學畢業的社會新鮮人,什麼都懂一點,很有潛力。 | 一個有十年經驗的心臟科醫生,你問他感冒他也會,但你問心臟問題他最強。 |

| 專長 | 範圍超廣,聊天、寫信、摘要文章,樣樣通但可能不夠深入。 | 在特定領域,像是醫療、法律、程式碼除錯,表現會非常非常精準。 |

| 彈性 | 超級高。你可以叫它做任何事,只是成果好壞不一定。 | 比較低。它的「世界觀」比較窄,專注在它的專業上。 |

| 訓練成本 | 天文數字...只有大公司玩得起,我們看看就好。 | 相對便宜很多,有點像是在巨人的肩膀上加工,所以很多新創公司都在做這個。 |

講這麼多,所以這東西在生活上到底能幹嘛?

理論講完了,來點實際的。這東西已經悄悄改變很多事了。

像是以前打給客服,轉接個五六次都還沒解決問題,真的很火大。現在很多公司的 chatbot,是真的能解決問題了,因為背後就是 LLM。我上次有個銀行帳戶的問題,那個 AI 助理不只幫我搞定,還解釋了整個處理方式,比人類客服還有耐心。

還有就是 AI 寫作夥伴。老實說,我自己是文字工作者,一開始也超怕被取代。但現在它反而變成我克服寫作障礙的超級好朋友。草稿、大綱、想點子...它真的超實用。

更酷的是寫程式。我身邊一些工程師朋友,現在都用 AI 來幫忙抓 Bug、寫一些重複性的程式碼,甚至解釋複雜的演算法。這不是要取代工程師,而是讓他們變得更強大。

該怎麼跟它「溝通」才能得到好答案?

好,這部分是實作指引了。跟 LLM 溝通是有技巧的,你不能像跟 Google 搜尋一樣丟關鍵字。

- 給它一個角色和情境:不要只說「幫我寫一封 email」,試試看「你現在是一位資深行銷經理,請用專業但親切的語氣,寫一封 email 給合作夥伴,跟他說明我們下季度的產品發表會延期了,並提出兩個替代方案。」你看,更精準的指令會讓結果好上十倍。

- 把它當成思考夥伴:不要只叫它給答案。你可以叫它「針對這個問題,提供三種不同的觀點」、「幫我腦力激盪一下,這個產品可以有哪些創新的應用場景?」

- 理解它的限制:大型語言模型的限制在於,它不會「思考」,只會「預測」。所以它講的「事實」你一定要去查證,特別是最近發生的事或很專業的領域。它很會一本正經地胡說八道。

- 多試幾種問法:如果第一個指令效果不好,換個方式問問看。有時候改幾個字,出來的結果會天差地遠。

來聊聊台灣跟國外的差別

說到這個,大部分人用的都是國外的模型,像 OpenAI 的 GPT 系列。它們很強大,因為它們讀了全球的資料。但這也有個問題,就是它們對本地文化的理解,有時候還是隔了一層。

不過呢,台灣自己其實也有在發展自己的大型語言模型喔。像是國家科學及技術委員會(國科會)就有支持一個叫「TAIWAN-LLM」的計畫。我去看了一下他們的資料,他們特別強調「可信賴」。這點就跟國外那種追求最強、最大模型的思路有點不一樣。台灣的模型更專注在...嗯...怎麼說,更符合台灣的用詞習慣、在地知識,而且努力減少偏見和假訊息。我自己是覺得,這蠻重要的,畢竟 AI 的答案如果充滿了國外的文化偏見,對我們來說也不見得是好事。

最後的真相...可能會讓你有點幻滅

講了這麼多,最後來個回馬槍。當我第一次真正搞懂這件事的時候,說真的,有點幻滅感。

那就是,LLM 其實...什麼都不懂。它沒有意識,沒有感情,不會思考。它只是個極度、極度複雜的模式匹配系統。它之所以看起來那麼聰明,只是因為它在海量的資料中,學會了「在這種情境下,一個有智慧的人類最可能會說出什麼樣的下一句話」。

它不是在讀你的心,它是在預測一個「最像答案的答案」。

這整件事就像一場史上最華麗的魔術。但說真的...對我們日常使用來說,這個魔術是真是假,好像也沒那麼重要了,對吧?結果好用,就夠了。

這個技術革命才剛開始,未來我們一定會看到更強的 AI 助理。重點是學會怎麼跟它們一起工作,而不是對抗它們。那個未來,其實已經來了。

對了,換你說說看,你用 AI 做過最讓你驚訝、或最讓你傻眼的事情是什麼?在下面留言分享一下吧!