最近ね、バーチャル試着がちょっと別モノになってきた件

バーチャル試着って聞くと、だいたい「服を合成してくれるやつでしょ?」くらいのイメージだと思うんだけど、ここ数日触ってた Flux Labs AI の新しいやつ、けっこう方向性変わってきた感じあるんだよね。

一応ざっくりいうと:

人の写真(モデル)と、服の写真(トップスとかワンピとか)をアップロードすると、AI がいい感じに合成して「もしこの人がこの服を着てたら」っていう画像を出してくれるツール。それ自体は前からあったんだけど、2025年2月あたりの初期版は、縦横比が 2:3 じゃないとダメだったり、出力解像度が低めだったり、「まあ動くけど、プロ用途だとちょっと惜しいよね」ってところが目立ってた。

で、今回のアップデートで一気に「仕事でちゃんと使えるライン」に寄ってきた感じがある。

一番大きいのは:

・出力が 1 メガピクセル級までいけるようになった(だいたい SNS や EC サイトなら余裕で実用レベル)

・入力画像の縦横比がかなり自由になった(2:3 強制じゃなくなった)

ってところ。しかも処理速度ほぼそのまま。

だから、前みたいに「うわ、この写真 4:5 だからわざわざトリミングし直さないと…」みたいな、地味にストレスな作業がかなり減る。

どこが変わった?って聞かれたらこのへん

細かく仕様書っぽく並べると味気ないから、先に体感ベースでいうと:

・解像感が素直に上がってる

・服のディテール(しわとか質感)がちゃんと見える

・画角をあまり気にしなくてよくなった

っていう「写真としてちゃんと見れるかどうか」のラインが一段階上がった感じ。

内部的には Fashn AI v1.5 っていうモデルが使われてるらしくて、海外の人が検証してる記事を見た限りだと、裏側に Google の Gemini 2.0 系が絡んでそう、みたいな話も出てた。もちろん公式に「Gemini 使ってます」とは言ってないから、そこはあくまで推測だけど。

ただ、モデルの名前が何であれ、「1MP 出せて、アスペクト柔軟で、速度落ちない」っていう事実のほうがユーザーからしたら大事なんだよね。

メリットを雑にまとめると:

- 出力サイズ:前より一回り大きいのに、待ち時間はほぼ同じ。

- 縦横比:2:3 の呪いから解放される。縦長でも横長でもそこそこ許容。

- ピンポイント最適化:必要なところ(人と服のあたり)にちゃんと解像度を割いてる感じがある。

UI が地味にありがたい方向に変わってる

モデルが新しくなった話と同じくらい、UI の変化も地味に効いてる。

ざっと触ったときに「あ、これは助かるな」って思ったのはこのへん:

- モデル画像と服画像、どっちもドラッグ&ドロップで放り込める

- 「スワップ」ボタンで、2枚をワンタップで入れ替えられる(再アップロード不要)

- 服のカテゴリ(トップス/ボトムス/全身)を「Auto」にしておけば、AI が勝手に判定してくれる

- 品質モードが「Performance / Balanced / Quality」で選べる

このあたり、触った人なら分かると思うけど、毎回ラベル選ばなくていいとか、地味な UI 改善が一番ストレス減らしてくれるんだよね。

逆に、古い v1.0 モデルを選んだときは:

・品質モードの選択肢が出てこない

・Auto カテゴリ検出もオフ

みたいな感じで、昔の仕様に合わせてくれてる。後方互換は残しつつ、「新しい方を使うときだけ便利機能が増える」っていう設計。

モデルの切り替えは Advanced Settings からできて、そこで細かいパラメータいじりたい人は好きにどうぞ、っていうポジション。

バーチャル試着、実際にどうやって使うのか一回整理しよ

「仕組みは分かったけど、どう準備すればちゃんと綺麗に出るの?」ってところが一番実用でつまづきやすいところなので、そこだけはちゃんと整理しとく。

バーチャル試着に必要なのはこの2つ:

- 被写体(Subject)画像:服を着せたい人の写真。

- 服(Garment)画像:合成したい服の写真。ハンガー掛けでも、誰かが着ている写真でもOK。

で、ここからがけっこう大事なところなんだけど、被写体画像については:

- 推奨は 2:3 の縦長(今は柔軟になったけど、やっぱりこの辺が一番安定しやすい)

- 体全体、少なくとも着せたい範囲はしっかりフレームに入っていること

- もともと着ている服は、できればタイトめのもの(ゆるだぼパーカーとかだと体のラインが拾いにくい)

- 被写体がちっちゃく写ってる遠景写真は避ける

- 解像度は高いに越したことはない(ぼやけてると AI も困る)

服の画像については:

- 服だけの写真でも、人が着てる写真でもOK

- できるだけ全体が見えていて、折りたたまれていないもの

- これもやっぱり高画質のほうが結果が綺麗

この辺、海外の EC 向けバーチャル試着ツールのガイドラインもだいたい同じこと言ってて、アメリカの事例だと「体のラインと服の輪郭がはっきり分かること」が最優先ってよく書かれてるんだよね。それと比べると、日本の EC 向けのチュートリアルって、まだ「解像度は大きめに」とかかなりふわっとした説明で終わってるところが多い印象。

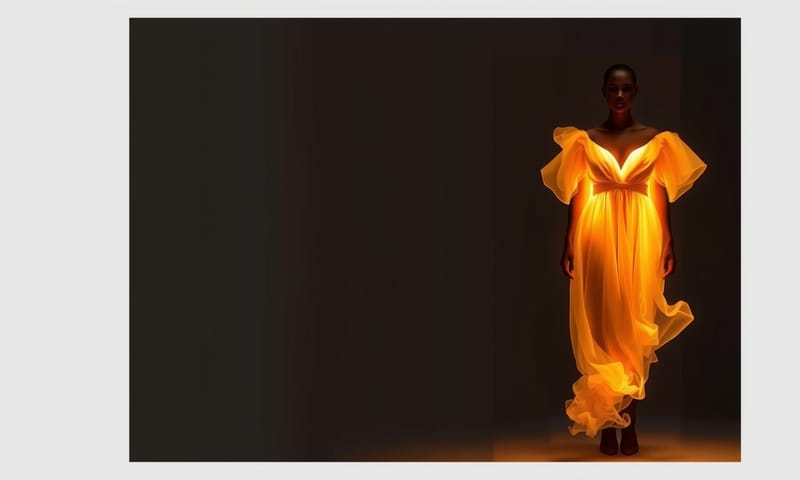

実際の出力イメージってどんな感じ?

例の画像たちを思い出しながらざっくり言語化すると:

・普通の女性モデルに別のワンピを着せ替えたパターン

・男性モデル同士で服だけ差し替えたパターン

・男性モデルの写真に、女性の服の写真を合わせたパターン

・AI で作ったモデル画像に、実写の服画像を合成したパターン

・全身ショットの被写体に、全身の服を合わせたパターン

みたいなのを一通り試しても、全部そこそこ自然にハマってた。

細かいところを見ると、首元とか、手と服の境目あたりに小さなアーティファクトが出ることはあるけど、ぱっと見で「ん?」ってなるレベルじゃない。SNS 用とか、EC のサムネくらいなら余裕で許容範囲。

面白いのは、「男性の被写体 + 女性が着ている服の写真」みたいな、性別をまたいだ組み合わせでも普通に動くところ。モデルは性別を気にせず、体の構造と服の形だけ見てフィットさせてる感じ。

ユニセックス系のブランドとか、ジェンダーレスなコーデ提案をしたいときには、むしろこの「性別を気にしない」性質がかなり強い武器になる。

画像で終わらせない:そのまま動画にしてしまうやつ

Flux Labs AI のちょっと面白いところが、バーチャル試着で作った画像を、そのまま動画に引き継げるところ。

UGC Video Generator っていう機能があって:

- さっき作った試着画像を 1 枚アップロード

- 「AI インフルエンサー」みたいな扱いで、その人に動いてもらう

- さらにテキストでセリフを書けば、声付きでしゃべらせることもできる

流れだけ分解すると:

- バーチャル試着で気に入った出力画像をダウンロード

- UGC Video Generator を開く

- 「No need for product photo」を選んで、AI influencer のところにその画像をアップ

- 動画の説明欄に「どう動いてほしいか」を文章で書く

例:

「ファッションフォトの撮影をしている女の子。いろんなポーズをとりながら、カメラのほうを見たり、軽くターンしたりする。」 - 動画の長さと品質レベルを設定

- Generate を押して、出力を待つ

品質を上げると生成時間はちょっと伸びるけど、そのぶん動きのなめらかさとか、服の揺れ方がだいぶ自然になる。

面白いのは、服の布が動いたときの「しわの寄り方」とか「裾の揺れ」が、静止画ベースの合成とは思えないくらいそれっぽいところ。海外の AI 動画系の検証を見てても、「布の物理表現」がどこまで再現されてるかってけっこう注目されてるポイントで、そこがちゃんと見れるのは単純に楽しい。

ここに声とスクリプトを足すと:

・試着したモデルが商品の説明をしゃべる

・ブランドストーリーを語る

・セール情報を案内する

みたいな「AI 店員さん」「AI インフルエンサー」っぽい使い方もできる。

なんでわざわざこれを使う意味があるのか

倫理の話とか、リアルとフェイクの線引きみたいなところは、正直これからどんどん議論されていくと思うし、「誰の写真をどう使うか」「同意はどう取るか」みたいな部分は絶対に雑に扱っちゃいけないところ。

それを踏まえたうえで、実利の部分だけを見ると:

- オンラインで服を買う人:

平面の物撮りだけじゃなくて、「自分に近い体型のモデルに着せたらこう見える」っていうイメージが先に持てる。 - アパレルのショップやブランド:

毎回スタジオ借りて、カメラマン呼んで、モデル手配して…っていう撮影コストをかなり削れる。服の写真さえあれば、バリエーション違いのコーディネートを大量に作れる。 - インフルエンサーやクリエイター:

毎回新しい服を買わなくても、フィード上の「服のバリエーション」だけはどんどん増やせる。

特に、動画までいけるってところが日本と海外で温度差が出そうだなと思ってて。

アメリカとかだと、UGC っぽい動画を AI で量産してテスト広告に回す、みたいな使い方がすでに当たり前になりつつあるけど、日本はまだ「AI が人をしゃべらせる」こと自体に抵抗感がある層も多い。だから最初は「静止画だけ」「顔は映さず後ろ姿だけ」みたいな、ソフトな入り方のほうが受け入れられやすいかもしれない。

正直なところ、自分としてはこう思ってる

個人的な感覚でいうと、バーチャル試着って「EC サイト用の便利ツール」っていうより、だんだん「コンテンツ制作の基礎インフラ」に近づいてきてる感じがある。

・モデル写真を 1 枚用意

・服の写真を何枚か用意

・試着でパターンを量産

・気に入ったものを動画にして、音声まで足す

この一連の流れが、全部ひとつのプラットフォームの中で完結しちゃうと、「じゃあ撮影どうする?」っていう発想自体がちょっと変わってくる。

海外の事例を見てると、「まず AI で仮のビジュアルと動画を全部作って、それで CTR とか CVR のテストを回してから、本番撮影するかどうか決める」ってやり方をしているブランドも出てきてて、これってもうほぼ「撮影前の A/B テストツール」なんだよね。

日本だと、まだそこまで踏み込んでるところは少ない印象だけど、

・EC の商品ページ用

・SNS のフィード用

・広告クリエイティブのテスト用

みたいに役割を分けて考えると、「とりあえず全部 AI で作ってから、反応よかったものだけ本気の撮影をする」っていう運用は、コスト的にも現実的になってくるはず。

あと、ちょっとだけ技術寄りの話をすると:

・1MP 級の解像度

・柔軟なアスペクト比

・動画へのスムーズな引き継ぎ

この3つが揃うと、「一度作ったアセットをどこまで使い回せるか」っていう再利用性が一気に上がる。SNS、EC、広告、LP、全部同じソースから派生させられるから。

じゃあ、触ってみるとしたら何からやる?

もし「ちょっと試してみたいな」くらいのテンションなら、いきなり全部やろうとしなくてよくて:

- 手持ちの全身写真(自分でも、フリー素材でも)を 1 枚用意

- 服の写真を 2〜3 パターン用意(できれば正面から、全体が写ってるやつ)

- バーチャル試着で何パターンか作ってみる

- その中で「これいいな」って思った 1 枚だけ、UGC 動画に流してみる

くらいのミニ実験から始めるのがちょうどいい気がする。

細かいパラメータは最初は全部デフォルトでいいし、Quality モードも、最初の数枚は Balanced で十分。慣れてきてから、

・「この服はディテール大事だから Quality にしよう」

・「とりあえずパターン出しだけなら Performance で枚数を稼ごう」

みたいな使い分けをしていくと、時間とクオリティのバランスが取りやすくなる。

…というわけで、長くなったけど、今のバーチャル試着まわりのアップデートってだいたいこんな感じ。

もし実際に触ってみて、「ここ微妙だった」「こういう機能ほしい」みたいなのが出てきたら、その辺りをメモしておくと、次にどのツールを選ぶかとか、どこにコストをかけるかの判断材料にもなると思う。

最後にひとつだけ。

あなたがもしオンラインで服を売っている側なら、「全部を AI に置き換える」のがゴールじゃなくて、「どこまでを AI に任せて、どこからを人の手でやるか」を決めるための実験ツールとして、一回使ってみるのがちょうどいい距離感かな、と個人的には思ってる。

あなたなら、まずどこから AI に任せてみる?商品ページ?インスタのフィード?それとも、テスト広告用のクリエイティブ?ちょっと想像してみて。