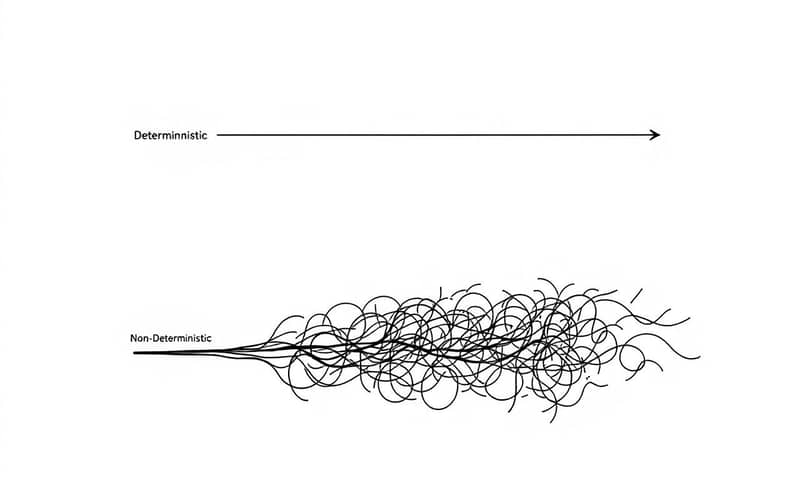

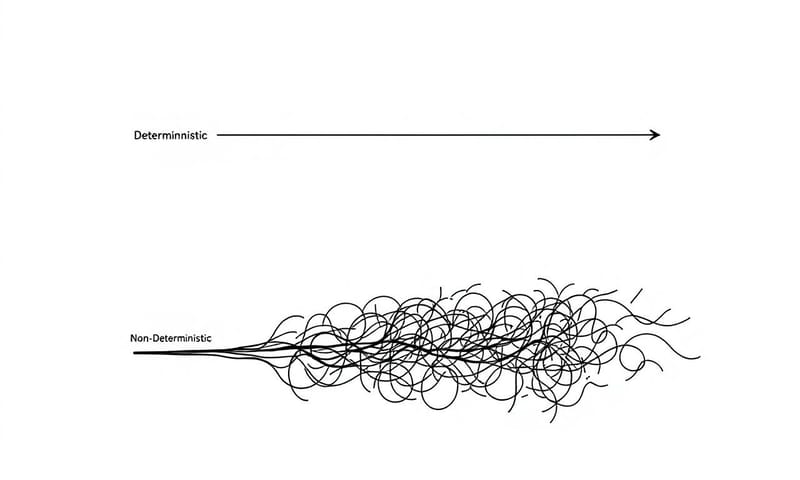

最近、AIについて考えてて、特に「信頼」ってどうやって作るんだろうって。ソフトウェアの世界では、「決定的」っていう言葉が、まあ、神様みたいなもんなんだよね。同じ操作をしたら、絶対に同じ結果が出る。それが当たり前で、そのおかげで僕らは安心してソフトウェアを使える。バグが見つかっても、再現できるから直せる。これ、基本中の基本。

でも、最近流行りの生成的AIとか、もっとすごいエージェントAIとかって、この「決定的」とは真逆の性質を持ってる。正直、ここが一番厄介なところなんだと思う。

そもそも「決定的」って何がそんなに偉いの?

なんでそんなにエンジニアが「決定的、決定的」って言うかっていうと、それが品質の土台だから。すごく単純な話で、予測できるからこそ、色々なことが可能になるんだよね。

- 予測可能性: 同じ入力なら、何度やっても同じ結果。これが一番大事。

- 一貫性: 実行する時間とか、マシンのちょっとした違いとか…そういう環境要因で結果がブレないこと。

- デバッグのしやすさ: 「一回だけ変な動きした」じゃなくて、「この操作をすれば必ずバグる」っていう状態にできるから、原因を突き止められる。じゃないと、ただの幽霊探しになるからね…。

- テストのしやすさ: 自動テストを書けるのは、このおかげ。期待する結果が一つに定まってるから、「OK」か「NG」かをはっきり判定できる。

まあ、要するに、ちゃんと「正しい」って言えるソフトウェアを作るための最低条件みたいなものなんだ。

で、AIはなんで「決定的」じゃないの?

ここからが本題。特に生成的AIやエージェントAIは、その仕組み上、「決定的」にはなれないように作られてる。むしろ、その「揺らぎ」こそが価値だったりするから、たちが悪いというか…。ちょっと、従来のソフトウェアと比べてみると、その違いがよくわかると思う。

| 比較対象 | 従来のソフトウェア | 生成的AI (例: ChatGPT) | エージェントAI (例: 自己学習するAI) |

|---|---|---|---|

| 動作の予測 | できる。というか、できないと困る。設計図通り。 | うーん、難しい。同じ質問でも毎回違う答えが返ってくる。それが「創造性」でもあるんだけど…。 | ほぼ不可能。周りの状況を自分で判断して動くから、何をするか開発者ですら完全には読めない。 |

| テストのしやすさ | 簡単。入力Aに対する出力Bをチェックすればいい。 | 正解が一つじゃないから、「正しい出力」を定義できない。「なんかいい感じ」みたいな曖昧な評価になりがち。 | 環境全体を巻き込むから、単体テストが意味をなさない。昨日うまくいったテストが今日は失敗する、みたいなことが普通に起こる。 |

| バグの再現性 | 100%再現できる(はず…)。だから直せる。 | ほぼ無理。「さっき変なこと言った」って言っても、もう一度同じことを言わせるのは至難の業。 | 論外かも。AIが何を「学習」してその行動に至ったのか、その内部状態を完全に再現するのは不可能に近い。 |

| 信頼性の根拠 | 厳密なテストと仕様書。論理的な正しさ。 | 大量のデータによる統計的な「それっぽさ」。確率論。 | 継続的な監視と、過去の実績。でも、明日の行動は保証されない。 |

この表を見てもらうと分かるけど…右に行けば行くほど、どんどん「管理できない」領域に入っていく感じがしない?生成的AIですら、従来のテスト手法はほぼ通用しない。それがエージェントAIになると、もう…ね。ブラックボックスの中身が常に動き回ってるみたいなもんだから。

じゃあ、テストできないものをどうやって信じるの?という大問題

ここが一番、僕が引っかかってるポイント。テストできない、ということは、品質を保証できないってこと。じゃあ、そんなAIが何か問題を起こした時、誰が責任を取るんだろう?

例えば、AIが医療診断をアドバイスしたり、融資の審査をしたり、自動運転をしたりする世界。もしAIの判断が毎回微妙に違って、その結果、損害が出たら?

今までのソフトウェアなら、話は簡単だった。「仕様書通りに動かなかった」とか、「テストケース○○が失敗した」とか、そういう客観的な証拠がある。だから、メーカーは責任を持って修正したり、保証したりできた。

でも、「AIの出力は確率的なもので、同じ結果を保証するものではありません」なんて言われたら?契約書にそう書いてあったら?これって、結構すごいことだと思わない?

日本には「製造物責任法(PL法)」っていうのがあるけど、こういう予測不能なAIが起こした問題に対して、今の法律でどこまで対応できるのか。すごく疑問。アメリカとかのテック企業は、もうこの辺りの法的なリスクをめちゃくちゃ考えてるはず。これは単なる技術の話じゃなくて、ビジネスと法律のど真ん中の問題なんだよね。

「説明可能性」は救世主になるか?

「AIがなぜその判断をしたのか、後から説明できる技術(XAI)があるから大丈夫」って言う人もいる。でもね、正直、それは気休めに近いんじゃないかな。後から「たぶん、こういう理由で判断したんだと思います」って説明できても、次に同じ判断をする保証はどこにもない。それって、バグの修正には繋がらないし、安全性の証明にもならない。

事故が起きてから原因を推測することと、そもそも事故が起きないように設計段階で安全性を証明することは、天と地ほど違う。今のAIにできるのは、前者だけ。でも、クリティカルなシステムに必要なのは、後者なんだ。

結局、僕らはどう向き合えばいいのか

別に、AIは危険だから使うな、なんて言うつもりは全くない。その能力は本当にすごいし、面白いことに使えるのは間違いない。ただ、「何でもできる魔法の箱」みたいに考えるのは、そろそろやめた方がいい。

AIは、決定的じゃない。だから、従来のソフトウェアと同じ感覚で「品質保証」とか「責任」を語ることはできない。この事実を、作る側も使う側も、ちゃんと理解しておく必要がある。

クリエイティブな作業を手伝ってもらうとか、ブレインストーミングの相手になってもらうとか、そういう「間違っても大したことない」領域で使う分には、最高のツールだと思う。でも、人の命や財産に関わるような領域に導入するなら…僕らが今まで築き上げてきた「信頼性の基準」そのものを、根本から考え直さないといけない時期に来てるんだろうね。それは、すごく面倒で、でも、すごく大事なことなんだと思う。

もしあなたの会社がAIを導入するなら、「予測できないリスク」と「革新的な能力」、どっちをより重視しますか?正直なところ、結構悩ましいですよね。もしよかったら、コメントであなたの考えを聞かせてください。