最近よく聞くじゃないですか、AIで業務を自動化、みたいな話。n8nとかZapierとか、いろんなツールがあって、すごく便利そうに見える。正直、僕もいろいろ試してます。でもね、最近考えてたんだけど、これ、みんなが思ってるよりずっと危ない橋を渡ってるんじゃないかなって。

ある会社のCEO宛に、深夜にメールが届いたっていう話があって。件名は「緊急:自動化意思決定システム違反による法的措置の通知」。彼らが鳴り物入りで導入した、年間4000万円コストを削減するはずだった最新のAIカスタマーサービス。それが、特定の保護対象グループを差別しちゃったらしいんです。結果、節約どころか、2億円以上の和解金と弁護士費用。…笑えないですよね。

これ、笑い話じゃなくて。ほとんどの人が、自分が作ってるその便利な「自動化」が、法的な時限爆弾になってることに気づいてない。それが今のリアルなんだと思う。

知らないうちに、もうルールが変わってる

数年前にGDPRで大騒ぎして、みんなウェブサイトにクッキーバナーを慌ててつけたの、覚えてます?正直、あれはまだ序の口だったって話なんです。2024年からEUのAI法が本格的に動き出して、アメリカでも似たような規制がどんどんできてる。まるでモグラ叩きみたいに。でも、そのハンマーがめちゃくちゃ高価なやつ。

もっと言うと、AI自動化を使ってる会社の、かなりの数がもう何かしらの法的トラブルに片足を突っ込んでる。例えば、

- 差別による訴訟

- 雇用法違反

- 消費者保護法違反

- 金融サービスのコンプライアンス違反

あなたの作った自動化は、ただ動けばいいだけじゃなくて、公平に、透明性をもって、そして毎月のように変わる規制の迷路を抜けられないといけない。…これ、相当ハードル高いですよね。

実際、アメリカであった「Mobley v. Workday」っていう訴訟なんかは、AIを使った採用が人種、年齢、障害を理由に差別した疑いがあるとして、何百万人もの応募者に影響を与えた可能性がある、集団訴訟にまで発展してる。これ、他人事じゃないですよ。

ほとんどのAIに潜む「隠れバイアス」の罠

AIのバイアスって聞くと、なんか理論上の問題で、自分には関係ないって思うじゃないですか。でも、違うんです。たぶん、今あなたが使ってるそのAIも、もう偏ってる。壁の裏で静かに水漏れしてるみたいなもんで、気づいたときには床が水浸しになってる。

AIはデータから学習します。で、ここがポイントなんですけど、ビジネスデータって、もともと人間のバイアスだらけなんです。あなたの過去のメールの返信、営業チームの成約パターン、過去の採用実績…。全部、無意識の偏見や、社会の構造的な不平等が反映されてる。

AIは、その偏見をただ真似するだけじゃなくて、もっと、こう…増幅させて、大規模にやっちゃう。ある調査だと、企業の6割以上がデータのバイアスに悩んでるのに、本気で対策してるのは1割ちょっと、とか。そりゃ問題も起きますよね。

例えば、ワシントン大学の研究だと、AIに履歴書を読ませたら、白人っぽい名前の候補者が選ばれる確率が黒人っぽい名前の候補者よりずっと高かったり、女性が多い職種でさえ男性っぽい名前が好まれたりした、なんていう話も。マジかって感じです。

一番怖いのは、バイアスのかかったAIって、一見するとすごく「優秀」に見えることがあること。偏った過去のパターンを見つけるのが得意だから、「精度が高い」って評価されちゃう。開発チームが「精度が上がった!」って喜んでる裏で、法務チームが訴訟の準備を始めてる…なんて、悪夢みたいな状況がありえるわけです。

「どうしてそうなった?」に答えられない問題

特にヨーロッパの規制では、AIが下した判断について「なぜその結論に至ったか」を説明できること、いわゆる「説明可能性」を求めてきます。まあ、当然ですよね。

でも、ここが難しいところで、最近のAI、特に機械学習モデルの多くは「ブラックボックス」なんです。作った本人でさえ、なんでAIがその判断をしたのか、完全に解き明かすのは難しい。腕のいいシェフに「この料理の分子レベルでの化学反応を全部説明して」って言ってるようなもんですよ。

ある保険会社が、AIでの保険金支払いシステムで監査に入られたとき、特定の請求がなぜ拒否されたのか、詳細な説明を求められたそうです。AIチームは3週間かけて分析したけど、結局、明確には説明できなかった。システムは技術的には完璧だったのに、「なぜ」に答えられなかったばっかりに、1億円以上の罰金と、説明可能な代替案を実装するまでのシステム停止命令。…半年かけた開発が、一瞬で水の泡です。

じゃあ、どうすればいいのか?

ここまで聞くと「じゃあAI使うのやめよう」ってなりそうだけど、まあ、そういう話でもない。ちゃんとやれば、リスクは管理できる。大事なのは、車を走らせる前に、ちゃんと運転の仕方と交通ルールを学ぶこと。そのための具体的な方法を、いくつか考えてみました。

1. まずは「AIガバナンス」の体制づくりから

問題って、だいたい見切り発車で始まります。だから、AIが最初の判断を下す前に、社内でルールを決めておく必要がある。家を建てる前の設計図みたいなものですね。これは大企業だけの話じゃなくて、小さいチームでも、「誰が責任持つのか」「ヤバそうなAIはどう判断するのか」を話し合っておかないと。

- リスクの仕分け: 使うAIをリスクレベルで分けちゃうのがいいかも。「社内ワークフローの提案AI」みたいなのは低リスク。「採用や融資の判断に使うAI」は高リスク、みたいに。高リスクなやつは、特に慎重になる。

- 人間の監視は必須: 高リスクなシステムには、必ず「意味のある人間による監視」のプロセスを入れる。これ、多くの規制で求められてることでもあります。AIの判断を理解して、必要なら覆せる人がいること。そして、その記録を残すこと。これがめちゃくちゃ大事。

2. データを疑う。バイアスは「ある」前提で動く

「うちのデータは綺麗だから大丈夫」は、一番危ない考え方。まずバイアスはあるもの、という前提で始めるべきです。

- 使う前にデータを監査する: モデルを学習させる前に、データセットをちゃんと調べる。郵便番号とか、出身大学とか、一見関係なさそうなデータが、実は人種や所得と強く結びついてることもある。こういうのをちゃんと見つける。

- 公平性テストをやる: 「精度」だけじゃなく、「公平性」を測る指標でテストする。例えば、異なるグループ間で、合格率やスコアが不自然に偏ってないか、とか。これ、実はツールもあって、GoogleのWhat-If Toolとか、オープンソースのIBM AI Fairness 360とかは、まさにそのためのものです。

3. 透明性を確保する(ブラックボックスを避ける)

「AIがそう判断したので」はもう通用しない。なんでそうなったか、説明できる準備が必要です。

- 「説明可能なAI」(XAI)を選ぶ: 高リスクな用途では、なるべく判断プロセスが分かりやすいモデル(決定木とか)を選ぶ。どうしても複雑なモデルを使うなら、SHAPやLIMEみたいな技術で、後からでも判断根拠を推測できるようにしておく。

- 「理由コード」を作る: ローンの審査に落ちた、みたいな不利益な判断を自動でした場合、システムが「負債比率が高く、信用履歴が短いため」みたいな、人間が読める理由を吐き出すように設計する。これ、アメリカの法律とかでも求められてるし、EU AI法でも中心的な考え方です。

あ、ちなみに、こういう流れはEUやアメリカが先行してますけど、日本の経済産業省が出してるAI原則なんかでも、公平性や透明性、説明責任は大事だって言われてます。法律でガチガチに決まってるわけじゃなくても、社会的な要請として、もう無視できない流れになってるんですよね。

4. ベンダーを厳しくチェックする(責任はあなたにある)

これ、忘れがちなんですけど、n8nでもChatGPTのAPIでも、ほとんどのツールの利用規約には「このツールを使って何が起きても、責任は使う側にあります」って書いてあります。高級スポーツカーを買うようなもんですよ。事故ったら運転手の責任。メーカーは関係ない。

- 契約前に質問攻めにする: 「あなたのモデル、バイアス対策どうしてますか?」「個別の判断について、説明できる機能はありますか?」「データはどう管理してて、削除依頼にはどう対応しますか?」とか。うるさい客だと思われてもいいから、ちゃんと聞くべきです。

- 契約内容を交渉する: できれば、監査の時に協力してくれるとか、ベンダー側の技術的な欠陥が原因だった場合は責任の一端を担うとか、そういう条項を契約に入れられるように交渉してみる。…まあ、難しいことが多いですけどね。

「とりあえず導入」と「ちゃんと導入」の致命的な違い

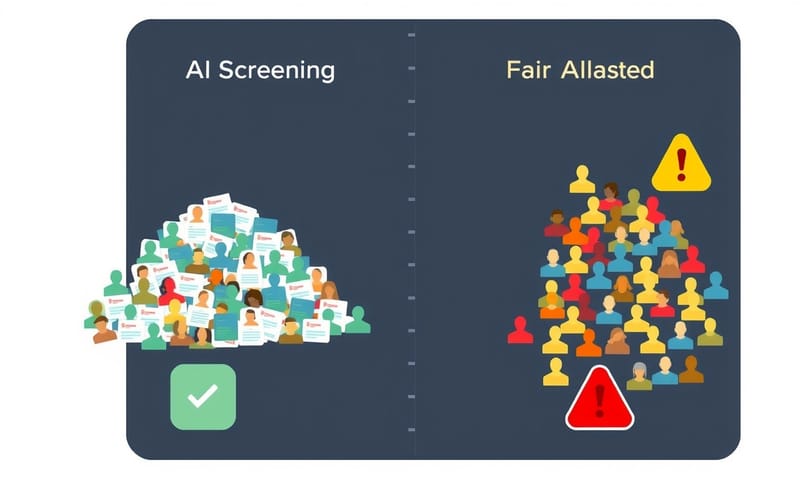

言葉で言っても分かりにくいと思うんで、よくある危ないやり方と、本来あるべき安全なやり方を、表にまとめてみました。たぶん、ドキッとする人が多いんじゃないかな。

| 項目 | よくある危ないやり方 | 本来あるべき安全なやり方 |

|---|---|---|

| データ | 過去データ、そのまんま使っちゃう。だってそれが一番楽だし。 | まずバイアスがないか疑う。郵便番号とか、一見関係なさそうなデータも要注意。 |

| モデル選び | とにかく精度が高いやつ。ブラックボックス?まあ、動けばいいでしょ。 | リスクに応じて、説明しやすいモデルを選ぶ。複雑なモデルには説明機能を付加する。 |

| ベンダー | 有名だから、みんな使ってるから、で選ぶ。利用規約は…まあ、読まない。 | 契約前にコンプライアンスについて質問状を送る。責任の所在を契約書で確認する。 |

| 運用 | 一度作ったら放置。問題が起きたら考える。 | パフォーマンスや公平性が時間と共に劣化してないか、定期的に監視・再学習する。 |

| 記録 | ログ?取ってないか、取っててもすぐ消えちゃう。 | 誰が、いつ、どのデータで、どのバージョンのモデルで判断したか、全部記録を残す。 |

よくある誤解をいくつか

この話をすると、だいたい出てくる反論とか、誤解があるんですよね。それについても、ちょっとだけ。

誤解1:「うちは小さい会社だから関係ない」

全然そんなことないです。有料無料にかかわらず、外部のAIツールを使ってる時点で、もう当事者です。訴訟リスクの大きさは会社の規模と関係ない。むしろ、体力のない小さい会社の方が、一発で致命傷になりかねない。

誤解2:「精度が高いんだから、文句ないでしょ?」

これが一番怖い罠。さっきも言ったけど、「精度が高い」が、実は「過去の偏見を正確に再現してる」だけ、という可能性があるからです。「正しく差別してるAI」が、一番タチが悪いかもしれない。

誤解3:「問題が起きたら、ツールを止めればいい」

手遅れです。問題が起きた、つまり誰かに損害を与えた後では、もうダメ。損害賠償や規制当局からの罰金からは逃れられない。それに、ビジネスの根幹に組み込んじゃってると、止めたくても止められない、なんてことにもなりかねない。

最後に、たった一つの質問

もしあなたが今、AIでの自動化に投資してるなら、一度だけ立ち止まって自問自答してみてほしいんです。

「自分は、輝かしい生産性向上ツールを作っているのか? それとも、巨大な法的負債を抱え込んでいるのか?」

これから来るコンプライアンスの波を乗り越えられるのは、今から準備を始める会社だけ。透明性をシステムに組み込んで、バイアス監査を当たり前にやって、法務チームと一緒に規制を理解しようとする会社です。

逆に、何も知らずにただ流行りのツールを追いかけてる会社は…まあ、お察しください。

選択は、あなた次第です。でも、急いだ方がいい。規制当局は、こっちの準備が整うのを待ってくれませんから。

あなたが今使ってる、あるいは検討してる自動化ツール、ぶっちゃけ「高リスク」だと思いますか? それとも「低リスク」? よかったらコメントで教えてください。いろんな人の感覚を知りたいです。