ファインチューニングって、結局なんなの?

最近よく考えてたんだけど、「ファインチューニング」って言葉、AIの話してると絶対出てくるじゃない?でも、じゃあそれって具体的に何?って聞かれると、意外と説明が難しい。正直、僕も最初そうだった。

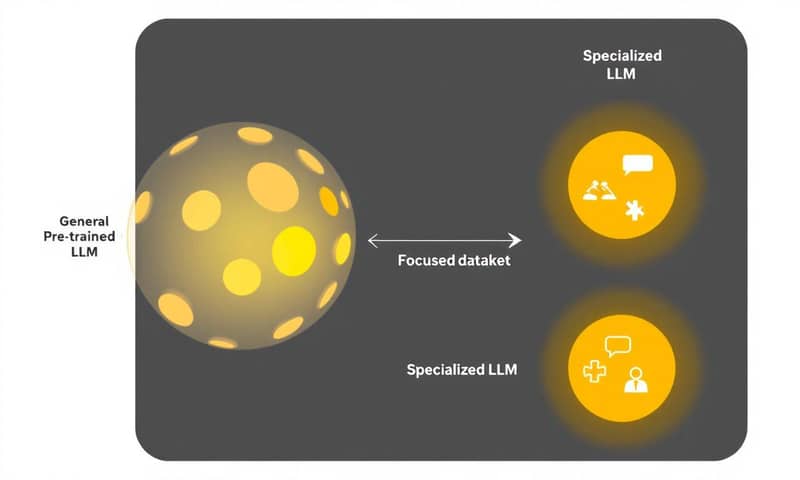

一言でいうなら…そうだな、「すでに賢いAIを、特定の仕事専用に再教育すること」かな。もともと、インターネットにある膨大なテキストを読んで「一般的な知識」を身につけた巨大な言語モデル(LLM)がいるわけ。でも、こいつはまだ「何でも知ってるけど、何かの専門家ではない」状態。これを、例えば法律の文書とか、医療系の論文とか、あるいは自社のカスタマーサポートの会話履歴とか…そういう、もっと狭くて深いデータセットを使って、追加で学習させる。これがファインチューニング。

だから、ゼロから巨大なモデルをトレーニングするっていう、無茶苦茶大変な作業とは違う。すでにある賢い土台を活かして、特定のタスクに特化させていく。そうすることで、その分野ではもっと精度が高くて、文脈を読んだ回答ができるようになるってわけ。

全部鍛え直す?それとも、ちょっとだけ?

で、このファインチューニング、やり方が大きく分けて2つあるんだよね。これが結構大事なポイントで。

一つは、モデルのパラメータ…つまり、モデルの脳みそを構成してる何十億っていう部品の重みを、全部調整し直すやり方。これを「フル・ファインチューニング」って言う。これはもう、徹底的にその分野の知識を叩き込む感じ。専門用語の使い方とか、特有の言い回しとか、深く学習できる。だから、法律の契約書とか、最先端の科学論文みたいな、本当に専門性が高い領域ではすごく効果的。

でもね、想像つくと思うけど、これ、めちゃくちゃ大変。計算リソースも大量にいるし、ストレージも食う。正直、個人とか小さい会社でやるのは、現実的じゃないことが多い。

そこで出てきたのが、もう一つのアプローチ。「パラメータ効率的ファインチューニング」、略してPEFT (Parameter-Efficient Fine-Tuning) ってやつ。こっちは、モデルの大部分のパラメータは「凍結」して、つまり、いじらないでおいて、ほんの一部だけを更新する。賢いやり方だよね。

このPEFTにはLoRAとか、Adapterとか、いろんなテクニックがあるんだけど、フル・ファインチューニングに比べて圧倒的に軽くて、速くて、安い。それでいて、多くの場合、性能はフル・ファインチューニングにかなり近いところまで出せる。だから今、実世界での応用ってなると、ほとんどの場合でこっちのPEFTが選ばれてる感じかな。

全部やるときの落とし穴:「破滅的忘却」

ちょっと待って、じゃあリソースさえあれば全部書き換える「フル・ファインチューニング」が最強なんじゃない?って思うでしょ。まあ、一理ある。でも、一つ大きなリスクがあって。それが「破滅的忘却(Catastrophic Forgetting)」っていう、名前からして恐ろしい現象。

これ、どういうことかっていうと、モデルのパラメータを全部更新しちゃうと、新しい専門知識を学ぶ代わりに、もともと持ってた一般的な知識を忘れちゃうことがあるんだ。例えば、医療データだけでファインチューニングしたら、すごく詳しいお医者さんAIにはなるけど、その代わり、日常会話の能力が落ちちゃったり、歴史の知識が抜け落ちちゃったり…。特化した分野以外のタスクで、性能がガクッと落ちることがあるわけ。

まあ、これを防ぐためのテクニックもあるんだけど、とにかく「全部更新すればいいってもんでもない」ってことは、頭の片隅に置いておくといいと思う。

賢いサボり方、PEFTのいろんな手法

じゃあ、賢く一部だけを更新するPEFTには、具体的にどんな方法があるのか。これもまた、いくつか流派みたいなのがあって面白いんだ。大きく3つのカテゴリーに分けられるかな。

- 追加式メソッド (Additive Methods)

これは、元のモデルは全く触らずに、新しい「パーツ」を後付けする感じ。Transformerブロックの間に「アダプター」っていう小さなニューラルネットワーク層を挟んだり、「ソフトプロンプト」っていう学習可能な埋め込みをくっつけたり。元のモデルは凍結されてるから、追加したパーツだけ学習すればいい。すごくメモリ効率がいいし、タスクごとにこのパーツを付け替えるだけ、っていう運用もできる。 - 選択式メソッド (Selective Methods)

これは、モデルの「既存の」パラメータの中から、一部だけを選んで更新するやり方。例えば、一番上の層だけをファインチューニングするとか、BitFitっていう手法だと、なんとバイアス項っていう部分だけを更新する。めちゃくちゃ軽量。ただ、どの部分を更新するのが一番効くのか、その見極めがちょっと難しいという側面もある。 - 再パラメータ化メソッド (Reparameterization-Based Methods)

で、これが今の主流かな。重みの「更新情報」そのものを、もっとコンパクトな形で表現しよう、っていう考え方。具体的には、「低ランク近似」っていう数学的なテクニックを使う。大きな行列を更新する代わりに、それとほぼ同じ効果を持つ、ずっと小さな行列の組み合わせを学習させる。これがね、効率と性能のバランスがすごくいい。

この中でも、特に業界のスタンダードになりつつあるのが、再パラメータ化メソッドの代表格、「LoRA」とその進化系の「QLoRA」なんだ。正直、今のファインチューニングの話は、この2つを知ってればだいたいOKってくらい重要。

みんな大好き「LoRA」って何がすごいの?

じゃあ、そのLoRA (Low-Rank Adaptation) がどういう仕組みなのか、もうちょっとだけ詳しく。ここがポイントで、わかると「なるほど!」ってなるはず。

LLMって、パラメータの塊でしょ。例えば70億パラメータのモデルなら、その重みは巨大な行列 `W` として表現されてる。ファインチューニングっていうのは、この `W` をどれだけ変化させるか、っていう更新量 `ΔW` を計算して、`W` に足し込む作業なんだよね。`W_new = W + ΔW` って感じ。

問題は、`W` が70億個の数字なら、`ΔW` も同じく70億個の数字の行列になるってこと。この巨大な `ΔW` をメモリに保持して計算するのは、GPUにとってものすごい負担。

そこでLoRAが考えたのが、「`ΔW` そのものを計算するんじゃなくて、`ΔW` を『近似』する、すごく小さな2つの行列 `A` と `B` を代わりに学習すればよくない?」っていうアイデア。つまり、 `ΔW ≈ A × B` としちゃう。

行列 `A` と `B` は、元の `ΔW` に比べて圧倒的に小さい。だから、学習するパラメータの数が劇的に減る。何十億じゃなくて、ほんの数百万とか。これにより、GPUメモリの使用量がガツンと減って、学習も速くなる。これがLoRAの魔法の正体。

ちなみに、LoRAには `r` (ランク)っていう設定値があるんだけど、これは行列AとBの「小ささ」を決めるもの。`r` を小さくすればもっと軽量になるけど、表現力が落ちて性能が出にくいかもしれない。逆に `r` を大きくすれば性能は上がるけど、メモリ使用量も増える。このへんは、ちょうどいい塩梅を探るトレードオフの関係だね。

さらに進化系「QLoRA」で、自宅PCも夢じゃない?

LoRAだけでもすごいんだけど、人間は欲張りで(笑)。もっと巨大なモデルを、もっと少ないリソースで動かしたい!って思うわけ。そこで生まれたのがQLoRA (Quantized LoRA)。

これはLoRAに「量子化 (Quantization)」っていう技術を組み合わせたもの。

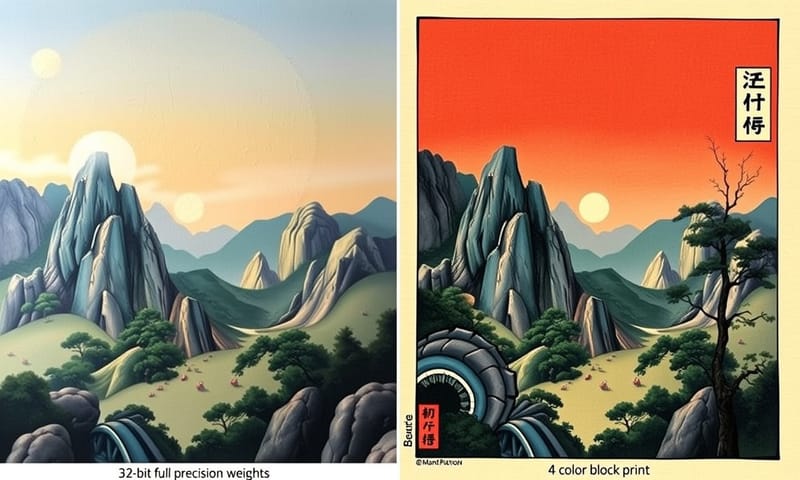

- まず、モデルを圧縮する(量子化)

もともと16ビットとか32ビットっていう精度で保存されてる、巨大な事前学習済みモデルの重み `W` を、なんと4ビットまで精度を落として圧縮しちゃう。これでまず、メモリ使用量が1/4とかになる。驚くべきことに、これでも性能はほとんど落ちないらしい。Hugging Faceの論文とか見ると、そういう結果が出てる。 - その上にLoRAを乗せる

この圧縮されて凍結されたモデルの上に、さっき説明した小さなLoRAアダプター(行列AとB)を追加する。で、学習するのはこのLoRAアダプターの部分だけ。

この合わせ技がヤバい。結果として、300億とか650億パラメータみたいな、これまでなら専門機関の巨大なサーバーでしか扱えなかったようなモデルのファインチューニングが、最新のゲーミングPCに積んでるような、単体のGPUでも可能になった。これはマジで革命的。AIの研究や開発が、一部の大企業だけじゃなくて、スタートアップとか個人の研究者にも一気に身近になったんだから。

で、結局どれを使えばいいの?

ここまで色々話してきたけど、じゃあ自分のプロジェクトでどれを選べばいいんだよ、ってなるよね。まあ、正解はないんだけど、僕なりの考えをまとめたのがこの表。

| 手法 | どんな時に選ぶ?(個人的な見解) | コスト感 | 注意点とか |

|---|---|---|---|

| フル・ファインチューニング | とにかく最高の性能が欲しい時。法律、医療、科学みたいに、専門性が超重要なドメインで、絶対に間違いが許されない場面。あと、計算リソースに糸目をつけない覚悟があるなら。 | 超高い。 GPUメモリも時間も、何もかもが必要。個人でやるのはほぼ無理ゲー。 |

あの「破滅的忘却」のリスクね。専門バカになっちゃって、他のことができなくなる可能性があるのは忘れずに。 |

| LoRA | これが今の「標準」かな。ほとんどのカスタムタスクはこれで十分だと思う。性能とコストのバランスがすごく良い。とりあえず迷ったらLoRAから試すのが定石。 | まあまあ安い。 フルに比べたら天国。一般的なクラウドGPUとか、ちょっといい個人PCでもいける範囲。 |

ランク `r` の調整がちょっとした職人芸かも。小さすぎてもダメ、大きすぎてもメモリ食うし。最初は8とか16あたりで試すのが多いかな。 |

| QLoRA | 手元のPCで、とにかくデカいモデルを触ってみたい!っていうロマンを追い求める時。メモリが本当にカツカツな環境で、なんとかしてファインチューVRAM 24GBのGPU一枚で70Bモデルを動かす、とかそういう世界。 | 激安。 LoRAよりもさらにメモリ効率がいい。AIの民主化を支えるヒーロー的存在。Hugging Faceのライブラリ(PEFTとかbitsandbytes)を使えば、実装も意外と簡単。 |

量子化してる分、理論上はほんの少しだけ性能が落ちる可能性はある。でも、大抵の場合は気にならないレベルっていうのがすごいところ。 |

まとめというか、今の気持ち

要するに、ファインチューニングっていうのは、汎用的なAIに「個性」と「専門性」を与えるための超重要なプロセスだってこと。昔は専門家だけの技術だったけど、LoRAやQLoRAみたいな賢い手法が出てきたおかげで、僕らみたいな個人開発者でも、巨大言語モデルを自分好みにカスタマイズできる時代になった。これって、すごくワクワクしない?

もちろん、ただやればいいってもんじゃなくて、元になるモデルの選定とか、学習データの質とか、考えることは山ほどある。でも、その第一歩として、どういう「育て方」があるのかを知っておくのは、めちゃくちゃ大事だと思うんだよね。

あ、ちなみに、こういう手法はだいたいHugging Faceの `peft` ライブラリに実装されてるから、Pythonコード数行で試せたりする。日本でもZennとかで「やってみた」系の記事がたくさんあるから、興味があったら見てみるといいかも。見てるだけでも面白いよ。

さて、これを読んでみて、もしあなたが何かプロジェクトをやるとしたら、どの手法に一番興味が湧きましたか?最高の性能を求めてフルチューニング?バランスのLoRA?それとも自宅のPCで巨大モデルを動かすQLoRA? よかったら、あなたの考えを聞かせてください。