最近よく聞かれる、NLP、NLU、NLGの話。これ、ごっちゃになってる人が結構多い。まあ、無理もないんだけど。AIの言語処理って話になると、大体この3つの単語が出てくるから。

正直、自分も最初は「え、何が違うの?」ってなったし。今日はその辺を、自分のメモみたいな感じで、ざっくり整理してみる。

TL;DR

いきなり結論から言うと、こんな感じ。

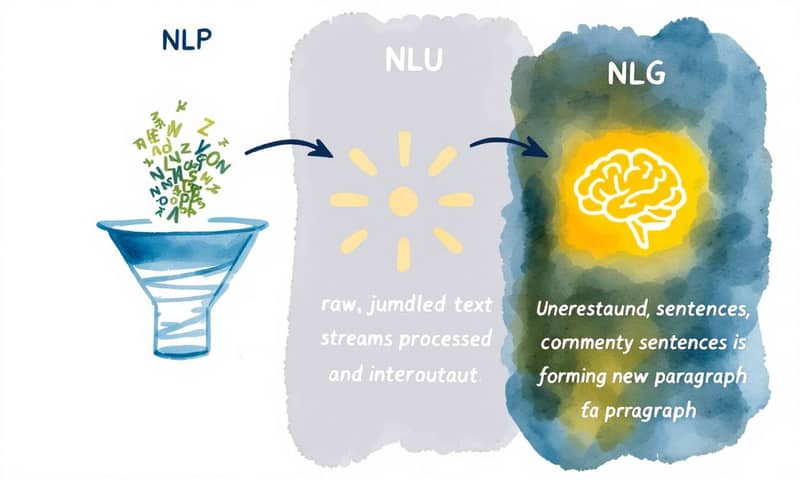

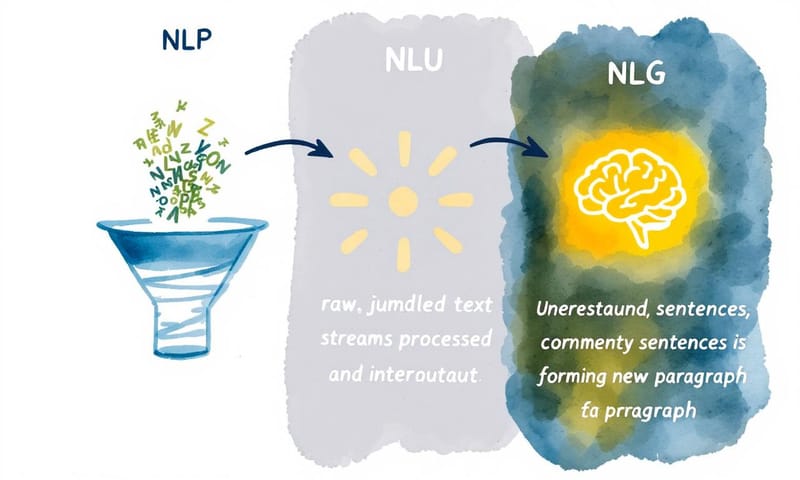

- NLP (自然言語処理):これが一番デカい枠組み。人間が話す言葉を、コンピュータが「処理」するための技術全部。料理で言えば「キッチン全体」。

- NLU (自然言語理解):NLPの一部。コンピュータが言葉の「意味」とか「意図」を理解するための技術。「食材の味見をして、これが何かを理解する」みたいな感じ。

- NLG (自然言語生成):これもNLPの一部。コンピュータがデータから「人間みたいな自然な文章を作る」技術。「レシピを考えて、美味しそうな説明文を書く」ってとこかな。

要するに、NLPっていう大きなキッチンの中で、NLUがインプット(理解)を担当して、NLGがアウトプット(生成)を担当してる。そんな関係性。

で、実際どう使われてるの?

理屈だけだとピンとこないから、具体的な話から。一番わかりやすいのが、多分カスタマーサポートの自動化システム。

お客さんから「製品が壊れた、動かないんだけど」ってメールが来るとするじゃない?

- まずNLPがそのメールを受け取って、文章を単語とか文節に分解する(トークン化っていうやつ)。「製品」「壊れた」「動かない」みたいなキーワードを拾い出す、いわば下ごしらえ。

- 次にNLUの出番。「壊れた」「動かない」っていう言葉と、文脈から「あ、これはクレームだな。しかも故障に関する問い合わせだ」ってお客さんの意図を理解する。怒ってるのか、困ってるだけなのか、その感情のニュアンスまで読み取ろうとする。これがすごい。

- 最後にNLGが動く。NLUが理解した内容(故障クレーム)に基づいて、「この度はご不便をおかけし申し訳ありません。故障対応についてご案内します」みたいな、ちゃんとした返信メールを自動で生成する。ただの定型文じゃなくて、相手の状況に合わせた文章を作れるのがポイント。

この一連の流れぜんぶが連携して、初めて「賢いAIチャットボット」が機能するわけ。面白いよね。

ビジネスインテリジェンス(BI)の世界でも同じ。昔は専門家が複雑なクエリを書いてデータベースを分析してたけど、今は経営者が「先月の西日本エリアで一番売れた商品なに?」って普通に話しかけるだけで、AIが答えをくれる。これも、NLUが「西日本エリア」「一番売れた商品」みたいな意図を汲み取って、NLGが「先月の西日本エリアでの売上トップ商品は『〇〇』で、売上高は…」って分かりやすいレポートを生成してくれるからできること。

聞いた話だと、アメリカのウォルマートとかはNLGを使って、何千もの店舗の業績レポートを毎週自動生成してるとか。JPMorgan ChaseはNLU搭載のチャットボットでデータ分析の時間を4割も削減したらしい。人の手でやったら、とんでもない時間かかる作業だよね。

じゃあ、それぞれの役割って何?

もうちょい、それぞれの技術的な部分を掘り下げてみる。まあ、あくまでざっくりと。

NLP (自然言語処理): すべての土台

これは本当に「全部入り」の分野。言葉をコンピュータに扱わせるための技術は、だいたいNLPに含まれる。歴史は意外と古くて、1950年代くらいから研究されてる。最初はルールベースで、人間が「この単語が来たら、こう処理する」って全部辞書みたいに作ってた。死ぬほど大変。

今は機械学習、特にディープラーニングが主流。コンピュータが大量の文章を読んで、自分でパターンを学ぶ感じ。主な仕事は、さっきも言ったけど、

- トークン化 (Tokenization): 文章を単語とかに区切る。

- 品詞タギング (Part-of-speech tagging): 「これは名詞」「これは動詞」ってタグ付けする。

- 構文解析 (Syntactic parsing): 主語と述語の関係とか、文の構造を分析する。

こういう地味な下処理がほとんど。でもこれが無いと、NLUもNLGも何もできない。まさに縁の下の力持ち。

NLU (自然言語理解): 空気を読むのが仕事

NLPが処理したデータから、「で、結局何が言いたいの?」を理解するのがNLU。ただ単語を拾うだけじゃなくて、文脈を読むのが得意。

例えば、「このPC、熱いね」って言われた時。これが「PCの性能が良くてすごい」っていうポジティブな意味なのか、それとも「熱暴走しててヤバい」っていうネガティブな意味なのか。NLUは前後の会話とか、言い方(テキストなら使われてる絵文字とか)から、その意図を判断しようとする。

皮肉とか、冗談とか、慣用句の理解もNLUの領域。まだまだ完璧じゃないけど、最近のモデルはかなり賢くなってて、「結構です」が肯定なのか否定なのかを文脈で判断できるレベルにはなってる。

NLG (自然言語生成): 言葉を紡ぐアーティスト

NLUが理解した意図や、分析されたデータ(例えば株価の数字の羅列とか)を、人間が読んで自然に感じる文章に変換するのがNLG。こっちはアウトプット専門。

NLGのプロセスも結構段階があって、

- 何を伝えるか決める (Content determination): データの中から、一番大事な情報をピックアップする。

- どう構成するか決める (Document planning): その情報をどんな順番で話すか、全体の構成を考える。

- どう表現するか決める (Microplanning & Surface realization): 具体的な単語を選んだり、文法を整えたりして、最終的な文章を生成する。

天気予報アプリが「気温25度、湿度60%、降水確率10%」っていうデータから、「今日は過ごしやすいお天気ですが、念のため折りたたみ傘があると安心です」みたいな文章を作るのが、まさにNLGの仕事。

この3つの違いをざっくり表にすると、こんな感じかな。

| 項目 | NLP (自然言語処理) | NLU (自然言語理解) | NLG (自然言語生成) |

|---|---|---|---|

| 役割を一言で | 言葉を「処理」するための技術全部。いわば司令塔。 | 言葉の「意味・意図」を理解する。インプット担当。 | データから「自然な文章」を作る。アウトプット担当。 |

| 主な目的 | テキストや音声を、コンピュータが扱えるデータに変換・構造化すること。下ごしらえがメイン。 | 構造化されたデータから、文脈とか話し手の本当の狙いを読み取ること。まあ、空気を読むってことだね。 | コンピュータが持ってるデータを、人間が読んで意味のわかる文章に変換すること。翻訳家みたいな。 |

| 具体例 | 迷惑メールフィルタ、機械翻訳の裏側、文章のキーワード抽出。地味だけど超重要。 | チャットボットがこっちの言いたいことを汲み取ってくれる機能。「お腹すいた」でレストランを薦めてくるやつ。 | 決算データからサマリーレポートを自動生成したり、スマートスピーカーが滑らかに喋ったりする部分。 |

| 難しさ | 言語の曖昧さ全部。日本語みたいに主語が省略される言語は特に大変。 | 皮肉、冗談、文化的な背景の理解。これはマジで難しい。「いい天気ですね」が会話の始まりなだけとか。 | ただ情報を並べるんじゃなくて、人間みたいに「自然で」「面白い」文章を作ること。創造性の領域。 |

最近のやつ、特にTransformerとかLLMの話

この分野がここ数年で爆発的に進化したのは、間違いなく「Transformerモデル」のおかげ。Googleが発表したBERTとか、OpenAIのGPTシリーズとか。これらが登場してから、NLUの精度もNLGの自然さも、次元が変わった。

特にGPTみたいな大規模言語モデル(LLM)は、もうNLUとNLGの境界線を曖昧にしてる感じすらある。大量のテキストを学習して、文脈を理解する(NLUっぽいこと)と同時に、自然な文章を生成する(NLGそのもの)ことができるから。

あ、ちなみに、こういう話ってどうしてもアメリカの巨大テック企業の話題が中心になるけど、日本でも面白い動きはある。例えば、理化学研究所のAIPセンター(革新知能統合研究センター)とかは、医療や科学論文みたいな専門分野に特化した日本語のLLMを研究してる。これはすごく大事なことで、GPTみたいな超汎用モデルもすごいけど、特定の業界で本当に使えるAIを作るには、やっぱりその分野の深い知識が必要だから。

海外のモデルをそのまま日本語に適用するだけだと、文化的なニュアンスとか、業界特有の言い回しとかで、どうしてもズレが出る。その点、日本国内でのこういう研究は、日本語のNLU/NLGの精度を上げる上でめちゃくちゃ重要なんだよね。アプローチの違いが面白い。

でも、万能じゃないよね

ここまで良いことばっかり言ってきたけど、もちろん課題も山積み。マジで気をつけないと、って思う点がいくつかある。

一つは「バイアス」。AIは学習したデータに影響されるから、データ自体に偏りがあると、AIの判断も偏る。例えば、過去のデータで特定の属性の人がネガティブに書かれることが多かったら、AIもその属性に対して偏見を持った文章を生成しかねない。これは本当に根が深い問題。

あとは「プライバシー」。特に医療記録とか、個人のメールとか、センシティブな情報をAIに食わせるわけだから、その管理は徹底しないと大事故になる。

それに、結局のところ、人間の言語の複雑さを100%理解するのはまだ無理。文脈依存の意味とか、その場の空気とか...そういう曖昧な部分をAIが完璧に読み取るのは、まだ先の話かな。Transformerモデルでかなりマシになったけど、それでも完璧じゃない。

最後に、身も蓋もない話だけど「コスト」。GPT-4みたいな最新のLLMを動かすには、とんでもない計算資源と電力が必要。だから、誰でも気軽に使えるかっていうと、まだそういうわけでもない。中小企業が自前で大規模なモデルを運用するのは、正直、現実的じゃないことが多い。

よくある勘違い

最後に、この辺の話でよくある誤解をいくつか。

- 「SiriやAlexaはNLUだけでできてる」

これは間違い。ユーザーの「〇〇を再生して」っていう言葉を理解するのはNLUの仕事だけど、その前に音声をテキストに変換する処理(広義のNLP)が必要だし、適切な返答「〇〇を再生します」を生成するのはNLGの仕事。全部が組み合わさってる。 - 「NLPは古い技術で、今はLLMの時代」

これもちょっと違う。LLMはNLPの分野に革命を起こした最新のツールだけど、LLM自体がNLPの一部。それに、今でも特定のタスク(例えば、単純なキーワード抽出とか)なら、LLMみたいな巨大なモデルを使わずに、もっと軽量な伝統的NLPの手法を使った方が効率的な場合もある。 - 「NLUとNLGは別々に開発するもの」

昔はそうだったかもしれないけど、今は違う。特にTransformerベースのモデルは、一つのモデルで理解も生成も高いレベルでこなせる。Fine-tuning(微調整)によって、NLU寄りにしたりNLG寄りにしたりすることはあるけど、根っこの技術は共通してることが多い。

結局のところ、この3つは個別の技術っていうより、一つの大きな「言語知能」システムを構成するパーツって考えた方が、しっくりくるかもしれないね。どれか一つだけじゃ、大したことはできない。全部が連携して初めて、人間と自然に対話できるAIが生まれるんだから。

さて、あなたはこのNLP、NLU、NLGの技術、自分の仕事や業界でどんなことに一番使えると思いますか?もしよかったら、コメントで教えてください。