AI時代のデータリスクを最小限に抑え、自分の情報を守れる実践ガイド

- AIサービス利用前、少なくとも3つの主要規約項目を確認する

無意識な同意による個人情報流出リスクを下げられる

- 個人データ入力は10%未満に制限し、必要最小限だけ共有

漏洩や不正利用時の被害範囲が圧倒的に小さくなる

- 週1回はブラウザやアプリのプライバシー設定・履歴削除を習慣化

不要なデータ蓄積や第三者への追跡精度低下につながる

- "怪しい"と感じた新機能には即飛びつかず、7日以上様子を見る

"思わぬ情報収集型アップデート"から身を守りやすい

宿題をサボる子供時代とAIに飛びつく現代の学生たち

子どもたちのこと、そろそろ考えたほうがいいかもしれない。自分が子どもの頃、一つだけすごく嬉しかったことがあって、それは宿題をやらなくて済むことだった。親とか先生、それに他の子の親なんかは、たぶん何時間もかけて“子どもの”工作とか絵の宿題に取り組んでいたみたいだけど、正直なところ自分には宿題ってほとんど無駄に感じられた。どうしても避ける抜け道があれば、喜んで飛びついたと思う。それはまるでルパート・マードックが婚前契約書にサインする時のような熱意だった…かな?実際、母校のロンドン・スクール・オブ・エコノミクス(LSE)の学生のおよそ八割くらいがジェネレーティブAIを日常的に使っているらしいし、自分としてはそういう学生を責める気になれない。

利用規約はラスベガスの即席結婚? 知らないまま同意する危険性

でも、ルパート・マードックみたいに、誰と手を組むのかとか、その約束事がどうなってるかは知っておくべきなんだよね。製品の「利用規約」ってやつ、普段使ってるもののページ数も多いし、意味不明でわざと曖昧に書いてあることが多いから、まるでラスベガスの結婚式みたいに「はいはい」と言ってしまうこともある。でも、それが必ずしもいい選択とは限らない気がする。アトランティック誌のちょっと有名な調査によれば、普通の人が日常的に使う商品の利用規約を全部読むには、大体七十日くらいはかかる…らしいんだけど、本当かな?

TikTokやChatGPTが握る私たちのデータ、13年前とは違う脅威

正直言って、気になるのはあの研究が結構前の話、確か十年以上前だったと思うんだけど…TikTokなんて多分その後にできたし、ChatGPTも最近出てきたものだよね。で、それらの利用規約って、昔と比べるとかなり違う気がする。もっと幅広くて、いろんなことをカバーしてそうだし。SNSが私たちのプライバシーをどう扱ってきたか、オンラインで何しても追跡されてる感じはもう知ってる人も多いんじゃないかな。

それでさ、GoogleとかMetaみたいな、大手テック企業が生成AIに関わってるけど、彼らがまったく違う行動を取る理由ってあるんだろうか?まあ、多分そんなにないんじゃない?技術の進化スピードは規制の力や意欲を遥かに上回っちゃってるし、その辺りどうなるかわからないよね。

それでさ、GoogleとかMetaみたいな、大手テック企業が生成AIに関わってるけど、彼らがまったく違う行動を取る理由ってあるんだろうか?まあ、多分そんなにないんじゃない?技術の進化スピードは規制の力や意欲を遥かに上回っちゃってるし、その辺りどうなるかわからないよね。

AIは中古車セールスマン? 魅力たっぷりだが信用できるか

今、多くの人は生成AIの可能性に夢中になっているようですが、その社会的な革命的影響についてはあまり向き合おうとしていません。私にとって、生成AIを使うのは中古車のセールスマンと付き合うようなものです。一見よさそうで、とても説得力があるけれど、本当に「真実だけ」を語っていると信じられるでしょうか?多くの人間と同じように、AIも答えがわからない時には、ターゲットとなる相手に響くような話をでっち上げて、あなたがソースを確認しないことを期待しているように見えます。

タバコ産業と同じ過ち AI規制で政府が業界の言いなりになる時

歴史家として、情報源の信頼性は真実を見極めるうえでとても大事だってことはわかる。これ、たとえばタバコ業界なんかでも同じ話でさ。たばこの危険性がある程度知られるようになったと思ったら、今度はまた新しい商品、つまり「ヴェイプ」っていうやつが出てきて。面白いのは、そのヴェイプの規制について英国政府が相談した相手が、なんとあのタバコ会社だったって話もあるんだよね。そういう会社が利益を得るために動いているとなると、昔のタバコ問題と似たような構図になるわけで。

医者も一時期、「安全だよ」と言っていたとか言われてて、それに加えて子どもたちをターゲットにして習慣づけようとしているマーケティングもあったらしい。まあ全部確証はないけど、そういう話もちらほら聞く。

それで思い出すんだけど、今親たちは子どものスマホ依存を心配して「スマホなしの子育て」を推そうとしている。でも一方で教育現場では教育テクノロジー(エドテック)が結構強引に導入されつつあるみたいなんだよね。この辺りもちょっと皮肉というか…利益優先な感じが否めない気がするんだよなぁ。

要するにさ、政府や大企業が「誰から意見を聞くか」が社会問題を解決する上でかなり重要なのに、それがズレちゃうとまた同じ問題が繰り返される可能性高いんじゃないかな、と。ただそんな単純じゃないし色々難しいけど。

医者も一時期、「安全だよ」と言っていたとか言われてて、それに加えて子どもたちをターゲットにして習慣づけようとしているマーケティングもあったらしい。まあ全部確証はないけど、そういう話もちらほら聞く。

それで思い出すんだけど、今親たちは子どものスマホ依存を心配して「スマホなしの子育て」を推そうとしている。でも一方で教育現場では教育テクノロジー(エドテック)が結構強引に導入されつつあるみたいなんだよね。この辺りもちょっと皮肉というか…利益優先な感じが否めない気がするんだよなぁ。

要するにさ、政府や大企業が「誰から意見を聞くか」が社会問題を解決する上でかなり重要なのに、それがズレちゃうとまた同じ問題が繰り返される可能性高いんじゃないかな、と。ただそんな単純じゃないし色々難しいけど。

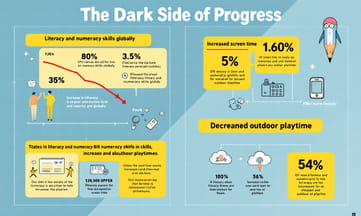

新しいからって進歩じゃない スマホが奪う子供たちの集中力

新しいものが必ずしも良くなっているとは限らない、というのはなんとなく当てはまる気がする。世界的に見ると、読み書きや算数のスキルがじわじわ下がっているらしいけど、複雑な原因を探すより単純に考えたほうがいいかもしれない。子供たちのスクリーンタイムは増えているけど、外で遊ぶ時間はその分減っている…そんな感じじゃなかったかな。自分の頃は、親からこんなギャンブルみたいにハマるデバイスを渡されて、先生の話に集中しろって言われた記憶はない。そういう機械で子供の目の動きまで監視されるなんて、一体誰のためなんだろう?宗教や国や政治を超える問題もあって、その中でも生成系AI技術の役割というか影響力は大きいと思う。まあ、それだけじゃなくて色々あるけど……

議論に勝つためのAIは知恵の実? 努力なしの学習には代償がある

子どもが道具を使えるからといって、それが理解しているのと同じだというのは、よくある誤解だけど、もっと暗い話題がある。たとえば、欲しい情報を何でも引き出してまとめられるツール…これって、議論に勝ちたい人にとってはまるでエデンの園でのリンゴみたいな誘惑かもしれない。苦労しなくて済むから楽なんだけど、それって一体何か代償があるんじゃないかな?学びにはやっぱり苦闘が必要だと思うんだ。これは単に自分が学生にそれを強いているから言うわけじゃなくて。試行錯誤したりミスを犯したりすることで、大事な概念が長く記憶に残る可能性が高まる…そんな感じかな。でも正直、その辺の仕組みも完全には把握できていない気もするし、まあ多少はね。

嘘が真実になる時代 BBCも間違える5%の事実確認ミス

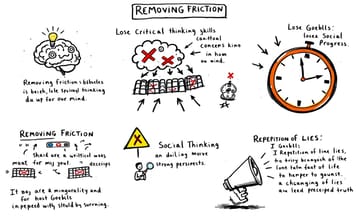

苦労を取り除くってことは、頭に概念をしっかりと刻み込むための摩擦をなくすみたいなもので、もっと怖いのは、自分がすでに強く持ってる意見に対して批判的に考える力まで失わせることだと思う。もし考え方を変えられなかったら、社会だって前に進めないんじゃないかな。ジョセフ・ゲッベルスが言ったのは、「嘘を何度も繰り返せば、それが真実になる」ってことで、彼は確かボット農場なんて持ってなかったと思うけど、それでもそうだったんだから。あと、自分が情報操作と戦ってると思い込むこと自体が、自分の偏見に気づけなくさせたりすることもあるよね。

ところで、UnHerdという調査でBBC Verifyについて調べたら、このBBCの検証チーム、結構驚きなんだけど、話題になったニュースの約数割ぐらいは訂正しちゃってるみたいで…普通だったらもっと少ないんじゃないかと思うけど。まあ、有名なニュース組織なのにそんな感じだから、人間っぽいと言えばそうなのかな、とか。でも本当のところどうなんだろうね…。

ところで、UnHerdという調査でBBC Verifyについて調べたら、このBBCの検証チーム、結構驚きなんだけど、話題になったニュースの約数割ぐらいは訂正しちゃってるみたいで…普通だったらもっと少ないんじゃないかと思うけど。まあ、有名なニュース組織なのにそんな感じだから、人間っぽいと言えばそうなのかな、とか。でも本当のところどうなんだろうね…。

AIが助長する人間の偏見 自分探しの記事ばかり読んでない?

BBCが新しいテクノロジーに惹かれすぎて、Bellingcatの真似をしようとした結果、もしかすると信頼性よりも斬新さを優先しちゃったのかもしれない。生成AIがかなりリアルなコンテンツを大量に作れる今、一部のジャーナリストは自分の意見を裏付けるためだけに技術に頼ってしまう傾向があって、それがちょっと怖い。まあ、確認バイアスへの誘惑を批判するつもりはまったくないけど、自分も昔から兄弟の中で長子は天才っぽいとかいう記事をかなり見てるし。ただ、こういう生成AIが人間の悪いところ、たとえば思考停止とかそういう面を助長するとしたら、それは水が岩をじわじわ削るみたいに確実に批判的思考力を蝕むよね。...で、その「次善」のタイミングって多分今くらいじゃないかな?

中国政府ですらティーンエイジャーと戦ってる AI対策は今すぐ必要

子どものことを考える、っていうのはよく聞く話だけど、まあそろそろ本気で考えないといけないんじゃないかと思う。中国政府が、TikTokにアクセスしたいちょっと荒っぽいティーンたちに立ち向かうのを恐れないなら、これから来るすごい技術に対しても何かしらの安全策をちゃんと作れるはずだよね。あれこれ手を尽くしてみてからじゃないと、賢く動けないってアッバ・エバンが言ってた気がするんだけど、「人や国は他の選択肢を使い果たしたあとにようやく賢明になる」みたいな感じだったかな。生成AIが私たち全員にどう影響するかについて、ピークの甘さはもう過ぎてることを願いたい。人生とか仕事とか子どもの教育に技術が及ぼす影響について考えるベストタイミングは、多分二十年くらい前だったと思うけど、その時逃しちゃった感もあるし…まあ今からでも遅くはない、と信じたいところ。